Complete Java Interview Questions

Hoành thành tổng hợp câu hỏi phỏng vấn Java

Info

Tổng hợp câu hỏi của toàn bộ, không phải chỉ về JAVA!

Sự khác biệt giữa JDK, JRE và JVM

- JDK (Java SE Development Kit) là bộ công cụ phát triển tiêu chuẩn của Java, cung cấp các công cụ và tài nguyên cần thiết để biên dịch và chạy chương trình Java, bao gồm trình biên dịch Java, môi trường chạy Java, và các thư viện lớp Java thông dụng.

- JRE (Java Runtime Environment) là môi trường chạy Java, được sử dụng để chạy các tệp bytecode của Java. JRE bao gồm JVM và các thư viện cần thiết để JVM hoạt động. Người dùng thông thường chỉ cần cài đặt JRE để chạy chương trình Java, trong khi nhà phát triển cần cài đặt JDK để biên dịch và gỡ lỗi chương trình.

- JVM (Java Virtual Machine) là máy ảo Java, một phần của JRE và là phần quan trọng nhất của Java để hiện thực hóa khả năng đa nền tảng, chịu trách nhiệm chạy các tệp bytecode.

Chúng ta có thể viết mã Java bằng một tệp tin txt, nhưng mã Java sau khi viết cần được biên dịch thành bytecode để có thể chạy được. Để làm điều này, ta cần trình biên dịch, và JDK bao gồm trình biên dịch javac. Sau khi mã Java được biên dịch thành bytecode, JVM (máy ảo Java) sẽ được sử dụng để thực thi bytecode đó.

Nếu chúng ta muốn phát triển chương trình Java, thì cần JDK để biên dịch các tệp nguồn Java. Nếu chỉ muốn chạy các tệp bytecode Java đã được biên dịch sẵn, tức là các tệp *.class, thì chỉ cần JRE. JDK bao gồm JRE, và JRE bao gồm JVM.

Ngoài ra, khi JVM thực thi bytecode Java, nó cần chuyển bytecode thành lệnh máy, mà lệnh máy trên các hệ điều hành khác nhau có thể khác nhau. Do đó, JVM trên các hệ điều hành khác nhau cũng không giống nhau, vì vậy khi cài đặt JDK, ta cần chọn đúng hệ điều hành.

Thêm vào đó, JVM chỉ thực thi bytecode Java, do đó bất kỳ mã nào sau khi biên dịch thành bytecode Java đều có thể chạy trên JVM, chẳng hạn như Apache Groovy, Scala, Kotlin,...

Mối quan hệ giữa hashCode() và equals()

Trong Java, mỗi đối tượng đều có thể gọi phương thức hashCode() của nó để lấy giá trị hash (hashCode), tương tự như dấu vân tay của đối tượng. Thông thường, không có hai dấu vân tay nào giống nhau hoàn toàn, nhưng trong Java, không thể đảm bảo điều này tuyệt đối. Tuy nhiên, ta vẫn có thể sử dụng hashCode để làm một số phán đoán ban đầu, ví dụ:

- Nếu hashCode của hai đối tượng khác nhau, thì chắc chắn chúng là hai đối tượng khác nhau.

- Nếu hashCode của hai đối tượng giống nhau, không đảm bảo rằng chúng là cùng một đối tượng, mà có thể là hai đối tượng khác nhau.

- Nếu hai đối tượng bằng nhau, thì hashCode của chúng chắc chắn giống nhau.

Trong một số lớp Collection của Java, khi so sánh hai đối tượng xem chúng có bằng nhau hay không, sẽ tuân theo nguyên tắc trên. Trước tiên sẽ gọi phương thức hashCode() của đối tượng để so sánh. Nếu hashCode khác nhau, có thể trực tiếp kết luận rằng hai đối tượng này khác nhau. Nếu hashCode giống nhau, sẽ gọi tiếp phương thức equals() để so sánh. Phương thức equals() là để xác định cuối cùng xem hai đối tượng có bằng nhau không. Thường thì phương thức equals() có logic so sánh phức tạp hơn và nặng hơn so với hashCode(), trong khi hashCode() chỉ trả về một giá trị số, nên nhẹ hơn và nhanh hơn.

Do đó, cần lưu ý rằng nếu chúng ta ghi đè phương thức equals(), thì cũng cần đảm bảo rằng phương thức hashCode() tuân thủ các quy tắc trên.

Sự khác biệt giữa String, StringBuffer và StringBuilder

- String là bất biến, nếu cố gắng thay đổi, sẽ tạo ra một đối tượng chuỗi mới. StringBuffer và StringBuilder là có thể thay đổi.

- StringBuffer an toàn trong môi trường đa luồng, trong khi StringBuilder không an toàn, vì vậy StringBuilder sẽ hiệu quả hơn trong môi trường đơn luồng.

Sự khác biệt giữa extends và super trong generic

<? extends T>biểu thị bất kỳ lớp con nào của T, bao gồm cả T.<? super T>biểu thị bất kỳ lớp cha nào của T, bao gồm cả T.

Sự khác biệt giữa == và equals

==: Nếu là kiểu dữ liệu cơ bản, so sánh giá trị; nếu là kiểu đối tượng, so sánh địa chỉ tham chiếu.equals: Tùy thuộc vào cách mỗi lớp ghi đè phương thức equals() sau đó. Ví dụ, với lớp String, mặc dù là kiểu đối tượng, nhưng lớp String đã ghi đè phương thức equals() để so sánh nội dung các ký tự của chuỗi.

Sự khác biệt giữa Overload và Override

- Overload: Trong một lớp, nếu các phương thức cùng tên có danh sách tham số khác nhau (như khác kiểu dữ liệu hoặc số lượng tham số) thì được coi là overload.

- Override: Là khi một lớp con ghi đè lại phương thức của lớp cha với cùng tên phương thức, cùng danh sách tham số và kiểu trả về (có thể là kiểu con của kiểu trả về phương thức trong lớp cha). Phương thức trong lớp con sẽ được sử dụng thay vì phương thức trong lớp cha. Lưu ý rằng quyền truy cập của phương thức trong lớp con không được nhỏ hơn lớp cha.

Sự khác biệt giữa List và Set

- List: Có thứ tự, lưu trữ các đối tượng theo thứ tự chèn vào, có thể trùng lặp, cho phép nhiều phần tử null, có thể sử dụng Iterator để duyệt các phần tử hoặc sử dụng get(int index) để lấy phần tử theo chỉ mục.

- Set: Không có thứ tự, không cho phép phần tử trùng lặp, tối đa chỉ có một phần tử null, chỉ có thể duyệt qua các phần tử bằng Iterator.

Nguyên lý hoạt động của ArrayList

- Khi khởi tạo ArrayList, nếu không chỉ định dung lượng, sẽ tạo một mảng rỗng. Nếu chỉ định dung lượng, sẽ tạo mảng có kích thước tương ứng.

- Khi thêm phần tử, trước tiên sẽ kiểm tra dung lượng của mảng có đủ không, nếu không đủ sẽ mở rộng, theo quy tắc tăng 1.5 lần. Sau khi dung lượng đủ, phần tử sẽ được thêm vào mảng.

- Khi thêm phần tử vào vị trí cụ thể, trước tiên sẽ kiểm tra chỉ mục có vượt quá giới hạn không, sau đó kiểm tra dung lượng, nếu không đủ sẽ mở rộng. Sau đó, phần tử mới sẽ được thêm vào vị trí chỉ định và các phần tử phía sau sẽ được dịch chuyển.

- Khi lấy phần tử tại chỉ mục, sẽ kiểm tra xem chỉ mục có hợp lệ không rồi lấy phần tử tương ứng từ mảng.

Sự khác biệt giữa ArrayList và LinkedList

- Cấu trúc dữ liệu khác nhau, ArrayList dựa trên mảng, LinkedList dựa trên danh sách liên kết.

- Do khác nhau về cấu trúc dữ liệu, ArrayList phù hợp hơn cho việc truy vấn ngẫu nhiên, trong khi LinkedList phù hợp hơn cho việc xóa và thêm phần tử. Độ phức tạp về thời gian của truy vấn, thêm và xóa cũng khác nhau.

- Cả ArrayList và LinkedList đều triển khai interface List, nhưng LinkedList còn triển khai thêm interface Deque, vì vậy nó có thể được sử dụng như một hàng đợi.

Cơ chế mở rộng của ConcurrentHashMap

Phiên bản 1.7

- ConcurrentHashMap 1.7 được triển khai dựa trên phân đoạn (Segment).

- Mỗi Segment tương đương với một HashMap nhỏ.

- Mỗi Segment sẽ tự thực hiện mở rộng, giống với cách HashMap mở rộng.

- Đầu tiên, tạo một mảng mới, sau đó chuyển các phần tử vào mảng mới.

- Mỗi Segment tự xác định khi nào cần mở rộng, bằng cách kiểm tra xem có vượt ngưỡng không.

Phiên bản 1.8

- ConcurrentHashMap 1.8 không còn dựa trên Segment.

- Khi một luồng thực hiện put mà phát hiện ConcurrentHashMap đang mở rộng, luồng đó sẽ tham gia vào việc mở rộng.

- Nếu không có quá trình mở rộng diễn ra, luồng sẽ thêm key-value vào ConcurrentHashMap và kiểm tra xem có vượt ngưỡng không, nếu có sẽ mở rộng.

- ConcurrentHashMap hỗ trợ nhiều luồng mở rộng cùng lúc.

- Trước khi mở rộng, sẽ tạo một mảng mới.

- Khi chuyển các phần tử, sẽ phân chia mảng cũ thành các nhóm và mỗi luồng sẽ chịu trách nhiệm chuyển một hoặc nhiều nhóm phần tử.

Những thay đổi từ JDK1.7 đến JDK1.8 trong HashMap (phần cơ bản)

- Trong JDK1.7, cấu trúc dữ liệu cơ bản là mảng + danh sách liên kết, trong JDK1.8 là mảng + danh sách liên kết + cây đỏ đen. Việc thêm cây đỏ đen nhằm nâng cao hiệu suất chèn và tìm kiếm trong HashMap.

- Trong JDK1.7, danh sách liên kết được chèn bằng cách chèn vào đầu, trong JDK1.8, danh sách liên kết được chèn bằng cách chèn vào đuôi, bởi vì trong JDK1.8, khi chèn cặp khóa và giá trị cần phải kiểm tra số lượng phần tử trong danh sách, do đó chèn vào đuôi là hợp lý.

- Trong JDK1.7, thuật toán băm khá phức tạp, bao gồm nhiều phép dịch phải và XOR, còn trong JDK1.8, thuật toán này đã được đơn giản hóa. Vì mục đích của thuật toán băm phức tạp là cải thiện tính phân tán, nhưng với sự bổ sung của cây đỏ đen trong JDK1.8, việc đơn giản hóa thuật toán này giúp tiết kiệm tài nguyên CPU.

Quy trình phương thức put của HashMap

Quy trình cơ bản của phương thức put trong HashMap:

- Tính chỉ số mảng từ khóa thông qua thuật toán băm.

- Nếu chỉ số đó trong mảng trống, thì đóng gói cặp khóa-giá trị vào đối tượng

Entry(trong JDK1.7 làEntry, trong JDK1.8 làNode) và đặt vào vị trí đó. - Nếu vị trí đó không trống, thì xử lý tùy theo trường hợp:

- Trong JDK1.7, kiểm tra xem có cần mở rộng không, nếu có thì thực hiện mở rộng, nếu không thì tạo đối tượng

Entrymới và thêm vào danh sách liên kết bằng cách chèn vào đầu. - Trong JDK1.8, trước tiên kiểm tra loại nút

Nodehiện tại, có thể là nút của cây đỏ đen hoặc danh sách liên kết.- Nếu là nút cây đỏ đen, đóng gói cặp khóa-giá trị thành một nút cây đỏ đen mới và thêm vào cây. Trong quá trình này, kiểm tra xem cây có chứa khóa hiện tại không, nếu có thì cập nhật giá trị.

- Nếu là nút danh sách liên kết, đóng gói cặp khóa-giá trị thành một nút danh sách liên kết mới và thêm vào đuôi danh sách. Trong quá trình duyệt danh sách, nếu phát hiện có khóa trùng, thì cập nhật giá trị. Nếu sau khi chèn mà danh sách có nhiều hơn 8 phần tử, thì chuyển danh sách liên kết thành cây đỏ đen.

- Sau khi thêm cặp khóa-giá trị vào danh sách liên kết hoặc cây đỏ đen, kiểm tra xem có cần mở rộng không, nếu cần thì mở rộng, nếu không thì kết thúc phương thức

put.

- Trong JDK1.7, kiểm tra xem có cần mở rộng không, nếu có thì thực hiện mở rộng, nếu không thì tạo đối tượng

Sự khác biệt giữa sao chép sâu và sao chép nông

Sao chép sâu và sao chép nông liên quan đến việc sao chép một đối tượng, trong đó có hai loại thuộc tính: kiểu dữ liệu cơ bản và tham chiếu đến đối tượng khác.

- Sao chép nông chỉ sao chép các giá trị của kiểu dữ liệu cơ bản và địa chỉ tham chiếu của đối tượng khác, không sao chép đối tượng mà tham chiếu đó trỏ đến. Kết quả là, các đối tượng sao chép nông có cùng tham chiếu đến một đối tượng chung.

- Sao chép sâu sao chép cả giá trị của kiểu dữ liệu cơ bản và sao chép cả đối tượng mà tham chiếu trỏ đến. Kết quả là, các đối tượng sao chép sâu có tham chiếu đến các đối tượng khác nhau.

Cơ chế mở rộng của HashMap

Phiên bản JDK1.7

- Tạo một mảng mới.

- Duyệt qua từng vị trí của mảng cũ và các phần tử trong danh sách liên kết tại vị trí đó.

- Tính lại chỉ số mảng mới cho từng phần tử dựa trên chiều dài mảng mới.

- Thêm phần tử vào mảng mới.

- Sau khi tất cả phần tử đã được chuyển sang mảng mới, gán mảng mới cho thuộc tính

tablecủa đối tượng HashMap.

Phiên bản JDK1.8

- Tạo một mảng mới.

- Duyệt qua từng vị trí của mảng cũ, bao gồm danh sách liên kết và cây đỏ đen.

- Nếu là danh sách liên kết, tính lại chỉ số và thêm từng phần tử vào mảng mới.

- Nếu là cây đỏ đen:

- Duyệt qua từng phần tử trong cây và tính chỉ số trong mảng mới.

- Nếu số phần tử tại một chỉ số lớn hơn 8, tạo một cây đỏ đen mới và thêm vào vị trí đó.

- Nếu số phần tử nhỏ hơn hoặc bằng 6, tạo danh sách liên kết và thêm vào vị trí đó.

- Sau khi tất cả phần tử đã được chuyển sang mảng mới, gán mảng mới cho thuộc tính

tablecủa HashMap.

Nguyên lý của CopyOnWriteArrayList

- CopyOnWriteArrayList sử dụng mảng bên trong để lưu trữ dữ liệu. Khi thêm một phần tử, nó sẽ sao chép một mảng mới, các thao tác ghi sẽ thực hiện trên mảng mới, còn các thao tác đọc sẽ thực hiện trên mảng cũ.

- Các thao tác ghi được khóa để ngăn ngừa sự cố ghi dữ liệu đồng thời.

- Sau khi kết thúc ghi, mảng cũ sẽ được thay thế bằng mảng mới.

- CopyOnWriteArrayList phù hợp với các tình huống đọc nhiều ghi ít, vì cho phép đọc trong khi đang thực hiện ghi mà không cần khóa đọc.

Bytecode là gì? Lợi ích của việc sử dụng bytecode là gì?

Bộ biên dịch (javac) sẽ biên dịch mã nguồn Java (*.java) thành tệp bytecode (*.class), giúp mã Java có thể biên dịch một lần và chạy ở nhiều nơi. Các tệp class có thể chạy trên nhiều hệ điều hành khác nhau. Tuy nhiên, để thực hiện điều này, các hệ điều hành cần có các phiên bản JDK hoặc JRE khác nhau, vì bytecode cần được chuyển thành mã máy khác nhau trên các hệ điều hành.

Lợi ích của việc sử dụng bytecode là giúp Java có khả năng đa nền tảng và tăng hiệu suất thực thi. Bộ biên dịch có thể tối ưu hóa mã trong quá trình biên dịch, chẳng hạn như loại bỏ khóa, thay thế đại lượng, hoặc nội tuyến phương thức.

Hệ thống xử lý ngoại lệ trong Java

- Tất cả các ngoại lệ trong Java đều bắt nguồn từ lớp cha cao nhất là Throwable.

- Throwable có hai lớp con chính là Exception và Error.

- Error đại diện cho các lỗi nghiêm trọng như

java.lang.StackOverFlowErrorvàJava.lang.OutOfMemoryError, thường những lỗi này không thể được xử lý bởi chương trình. Chúng thường là vấn đề ở cấp độ máy ảo, đĩa hoặc hệ điều hành, do đó, không khuyến nghị xử lý chúng trong mã vì chương trình có thể đã ngừng hoạt động. - Exception đại diện cho các ngoại lệ mà chương trình có thể xử lý, như

NullPointerExceptionhoặcIllegalAccessException. Chúng ta có thể bắt các ngoại lệ này để xử lý đặc biệt. - Các lớp con của Exception có thể chia thành hai loại: RuntimeException và Non-RuntimeException.

- RuntimeException là các ngoại lệ phát sinh khi chương trình đang chạy, là ngoại lệ không cần kiểm tra. Chúng ta có thể chọn bắt hoặc không bắt những ngoại lệ này, thường là do lỗi logic chương trình, ví dụ:

NullPointerException,IndexOutOfBoundsException. - Non-RuntimeException là ngoại lệ cần kiểm tra và bắt buộc phải xử lý, ví dụ:

IOException,SQLExceptionhoặc các ngoại lệ do người dùng tự định nghĩa.

- RuntimeException là các ngoại lệ phát sinh khi chương trình đang chạy, là ngoại lệ không cần kiểm tra. Chúng ta có thể chọn bắt hoặc không bắt những ngoại lệ này, thường là do lỗi logic chương trình, ví dụ:

Trong cơ chế xử lý ngoại lệ của Java, khi nào nên ném ngoại lệ và khi nào nên bắt ngoại lệ?

Ngoại lệ tương đương với một thông báo. Nếu chúng ta ném ngoại lệ, điều đó có nghĩa là phương thức hiện tại không thể xử lý và yêu cầu phương thức ở lớp trên xử lý. Lớp trên cũng cần quyết định xem có thể xử lý hay tiếp tục ném ngoại lệ cho lớp trên tiếp theo.

Khi viết một phương thức, cần cân nhắc liệu phương thức có thể xử lý ngoại lệ một cách hợp lý hay không. Nếu không, thì tiếp tục ném ngoại lệ. Nếu phương thức phát hiện ngoại lệ khi gọi một phương thức khác, và ngoại lệ này nên được xử lý tại đây, thì cần bắt và xử lý ngoại lệ đó.

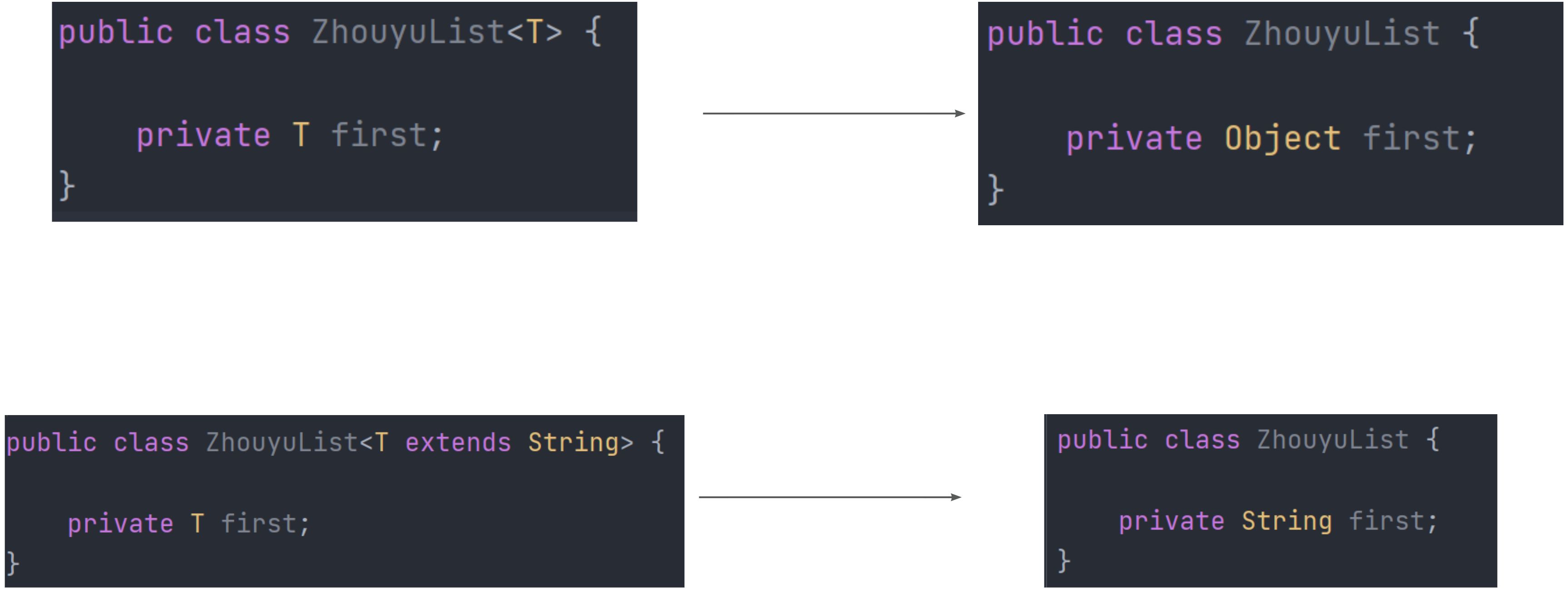

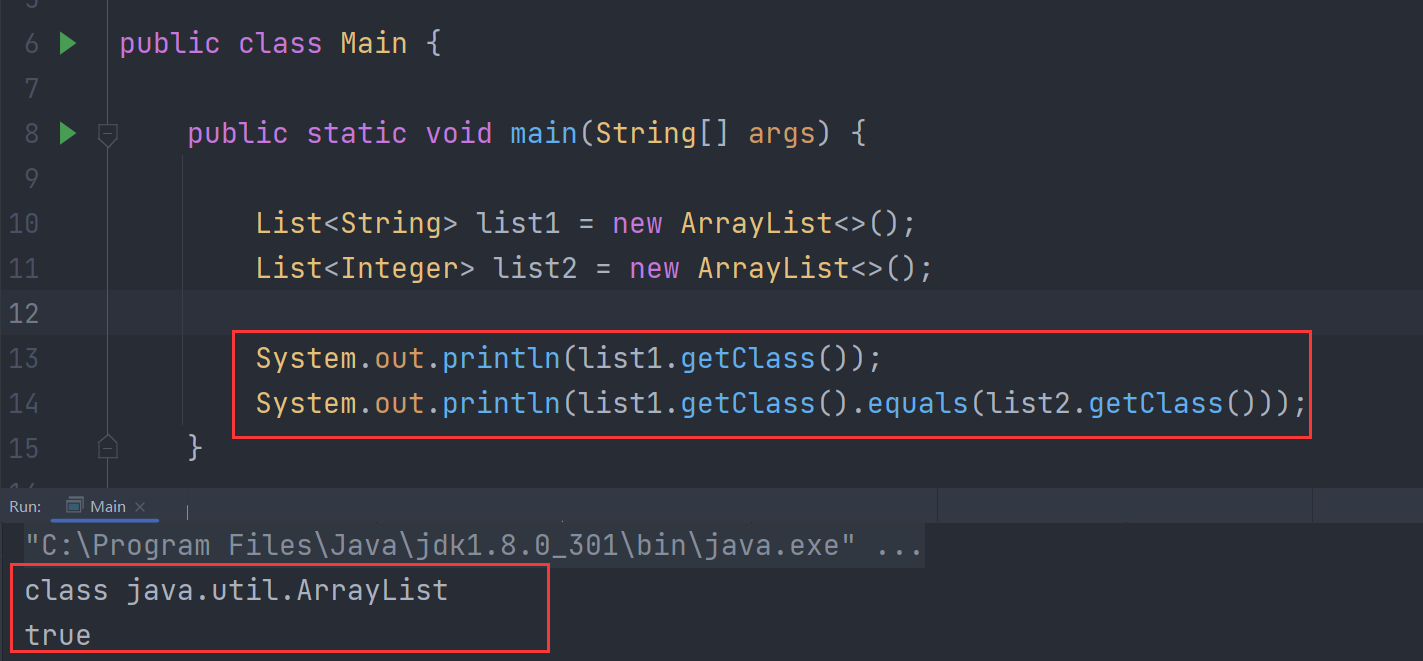

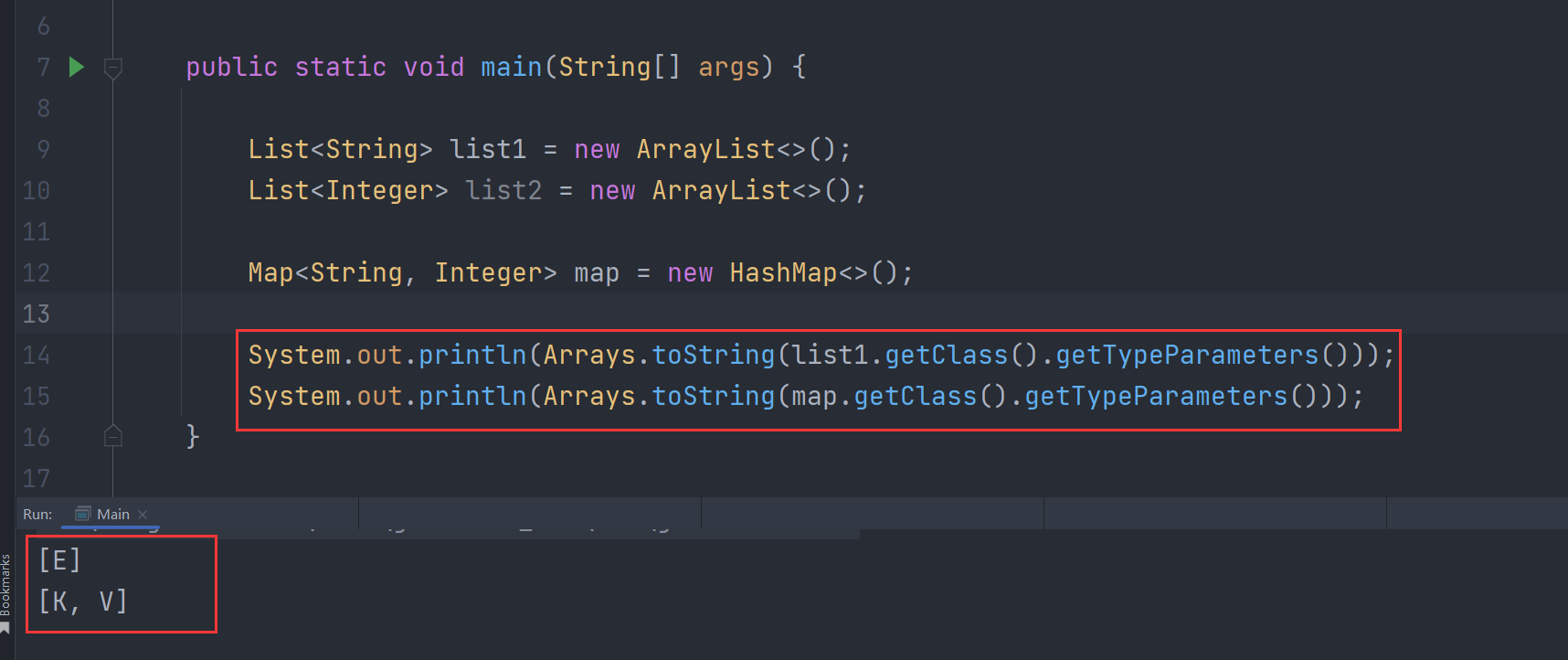

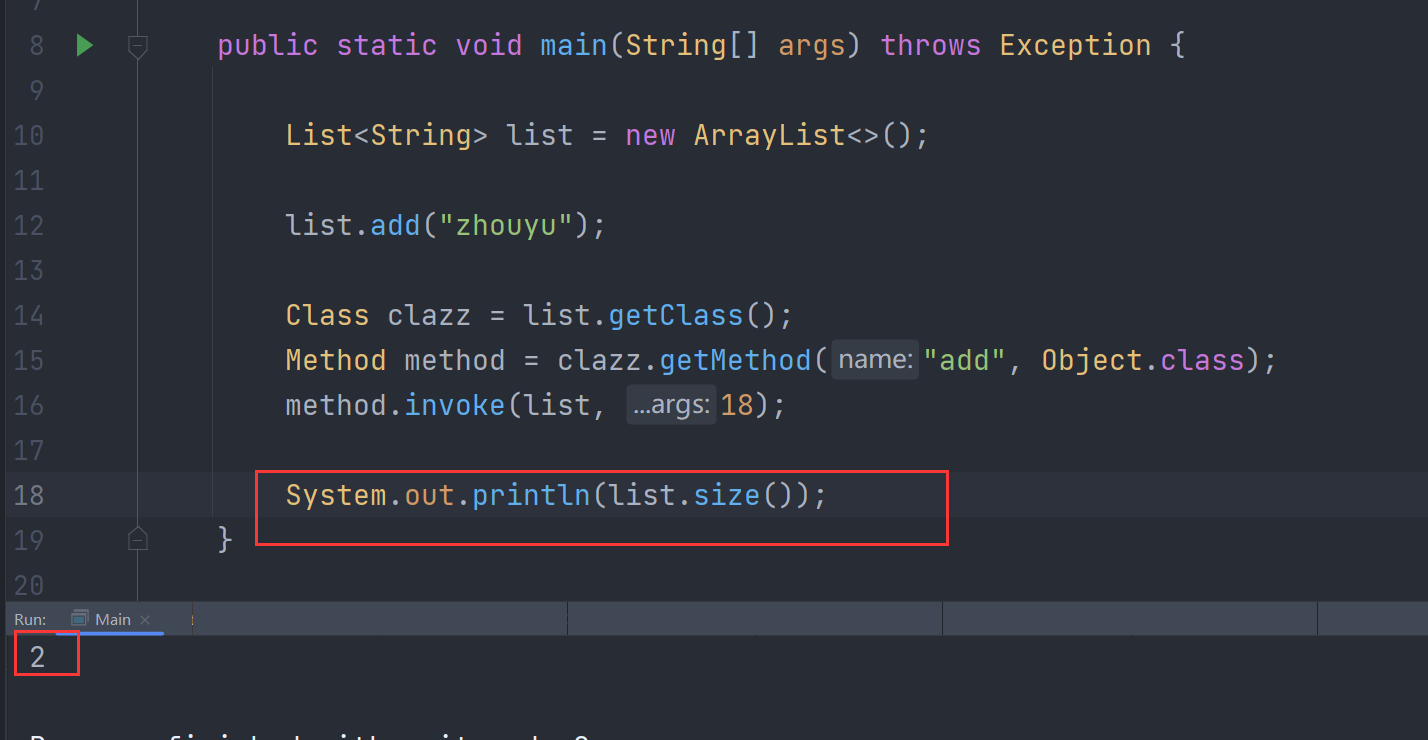

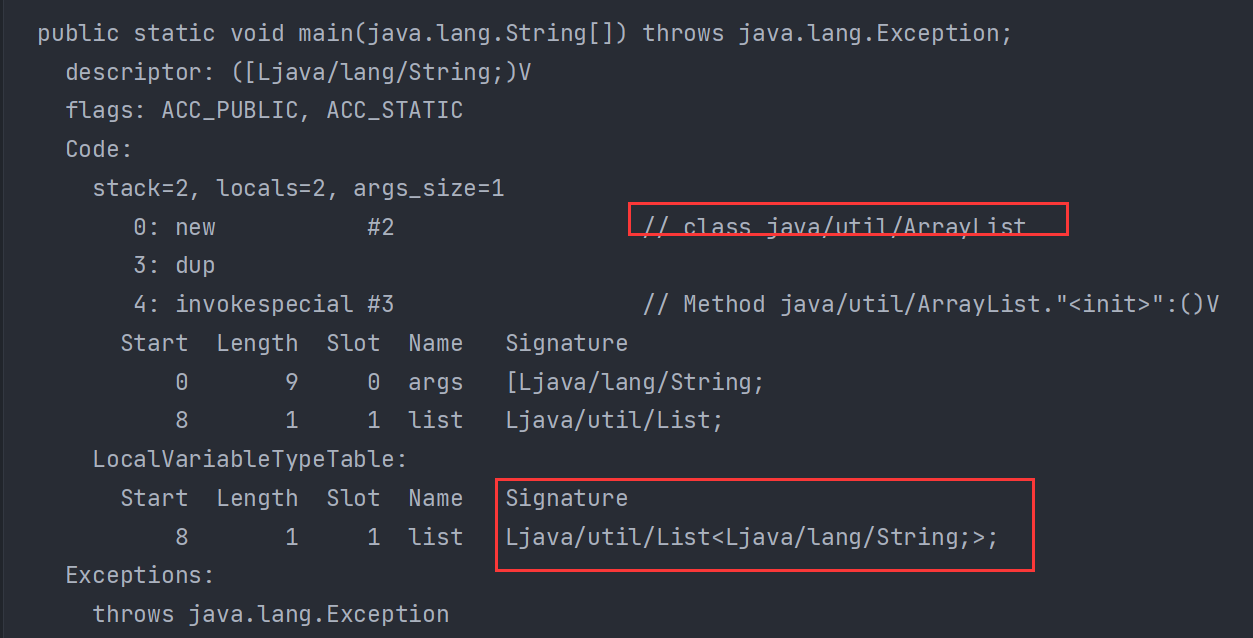

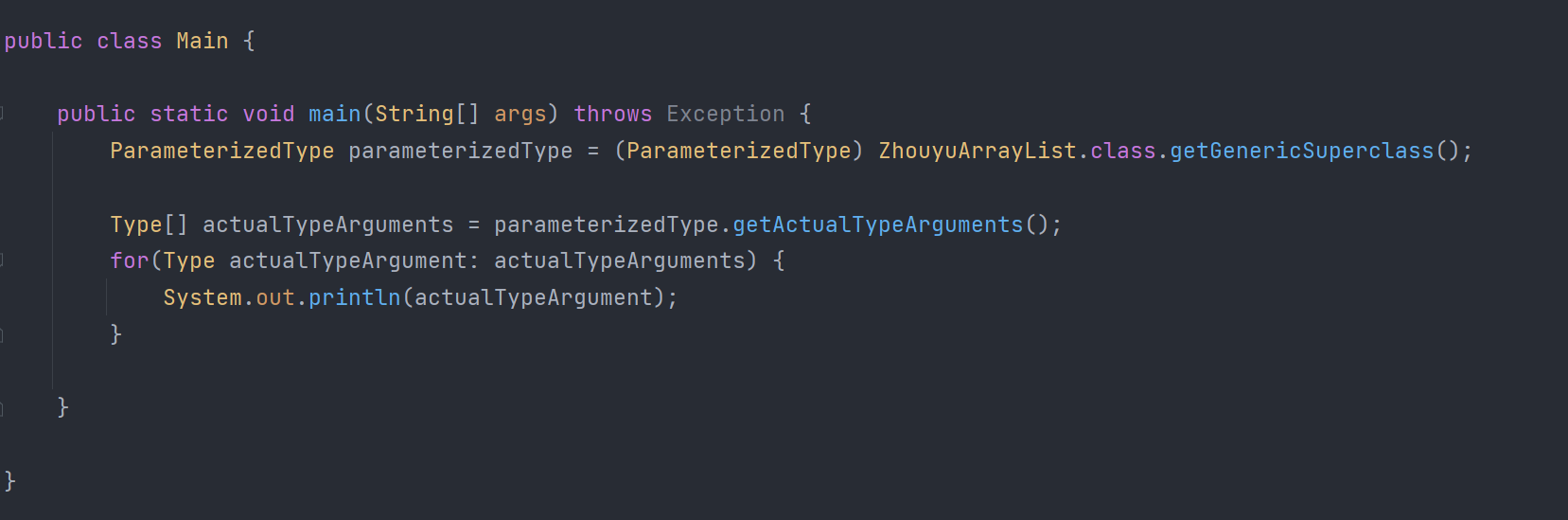

Generic Erasure trong Java là gì?

Trong JDK 1.5 và các phiên bản trước đó không tồn tại khái niệm về generic. Từ JDK 1.5 trở đi, khái niệm generic đã được giới thiệu để tương thích với các phiên bản JDK trước đó, từ đó khái niệm "generic erasure" (xóa bỏ generic) ra đời.

Dưới đây là hai kiểu tương đương, bề ngoài generic đã bị xóa bỏ, tất cả đều là ArrayList:

API dưới đây chỉ có thể lấy được số lượng generic, nhưng không thể lấy được loại cụ thể của generic:

Thông qua phản chiếu (reflection), ta có thể thêm các phần tử thuộc kiểu khác nhau vào danh sách (List), vì kiểu thực sự đã bị xóa bỏ, biến thành Object:

Mặc dù generic đã bị xóa bỏ, nhưng thông tin cụ thể về generic vẫn được lưu trữ trong bytecode:

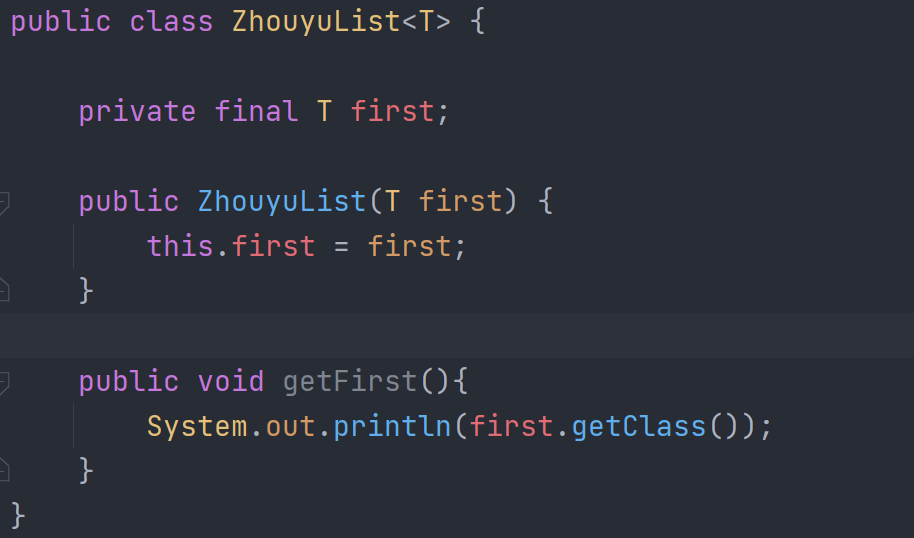

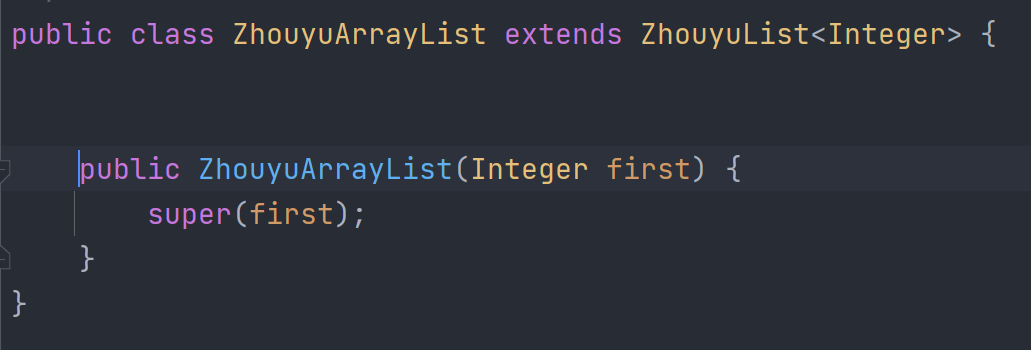

Do đó, vẫn có một số cách dễ dàng để lấy được kiểu thực sự của generic:

Ngoài ra, đối với JVM, nếu tạo mã mục tiêu cho từng loại generic khác nhau, giả sử có 10 danh sách (List) generic khác nhau, ta sẽ phải tạo ra 10 bytecode riêng, điều này sẽ không chỉ làm mã tăng kích thước mà còn làm một bytecode tương ứng với một đối tượng Class, chiếm rất nhiều bộ nhớ.

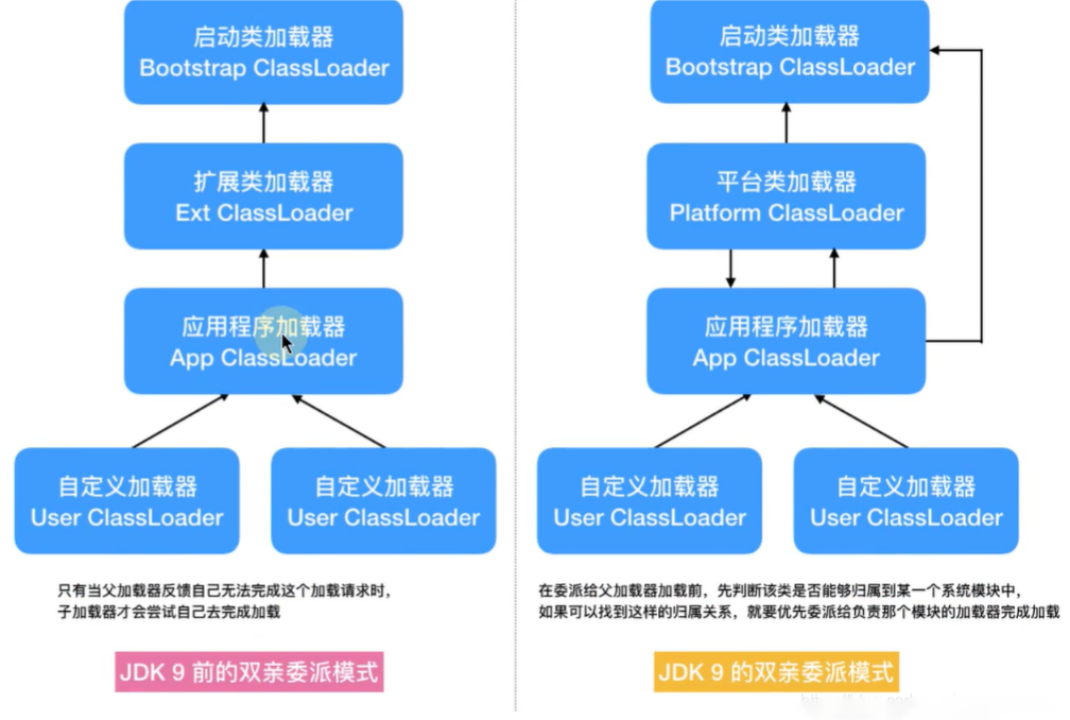

Các class loader trong Java

JDK tích hợp sẵn ba class loader:

- Bootstrap ClassLoader: Class loader cha của ExtClassLoader, chịu trách nhiệm tải các file jar và class trong thư mục

%JAVA_HOME%/lib. - ExtClassLoader: Class loader cha của AppClassLoader, chịu trách nhiệm tải các file jar và class trong thư mục

%JAVA_HOME%/lib/ext. - AppClassLoader: Class loader cha của các class loader do người dùng định nghĩa, chịu trách nhiệm tải các file class trong classpath.

Mô hình ủy quyền theo cha mẹ của class loader

Trong JVM có ba class loader mặc định:

- BootstrapClassLoader

- ExtClassLoader

- AppClassLoader

AppClassLoader có ExtClassLoader làm class loader cha, và ExtClassLoader có BootstrapClassLoader làm cha.

Khi JVM tải một lớp, nó sẽ gọi phương thức loadClass của AppClassLoader để tải lớp đó. Trong phương thức này, trước tiên nó sẽ gọi phương thức loadClass của ExtClassLoader để tải lớp. Tương tự, trong ExtClassLoader sẽ gọi phương thức loadClass của BootstrapClassLoader trước. Nếu BootstrapClassLoader tải thành công, quá trình sẽ hoàn tất. Nếu không, ExtClassLoader sẽ tự thử tải lớp, nếu không thành công, AppClassLoader sẽ tải lớp đó.

Vì vậy, mô hình ủy quyền cha mẹ đề cập đến việc JVM ủy quyền cho ExtClassLoader và BootstrapClassLoader tải lớp trước, nếu không thành công thì AppClassLoader mới thực hiện tải lớp đó.

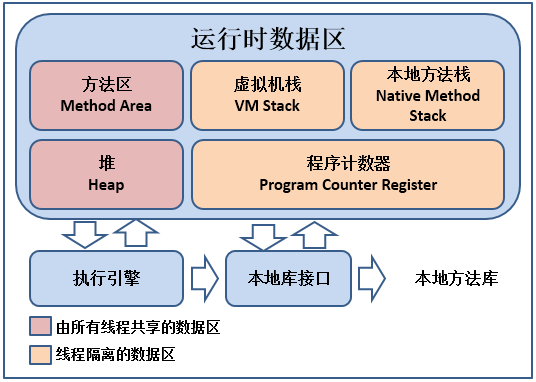

Những khu vực nào của JVM được chia sẻ giữa các luồng?

Vùng Heap và vùng Method là các khu vực được tất cả các luồng (threads) chia sẻ, trong khi Stack, Native Method Stack, và Program Counter là các khu vực riêng biệt của mỗi luồng.

Bạn xử lý các vấn đề JVM trong dự án như thế nào?

Đối với hệ thống vẫn đang chạy bình thường:

- Có thể sử dụng jmap để xem tình trạng sử dụng các vùng bộ nhớ của JVM.

- Dùng jstack để xem tình trạng hoạt động của các luồng, ví dụ như luồng nào bị khóa hoặc có xảy ra deadlock không.

- Dùng lệnh jstat để kiểm tra tình trạng thu gom rác (garbage collection), đặc biệt là full GC. Nếu thấy full GC xảy ra thường xuyên, cần tối ưu hóa.

- Phân tích kết quả của các lệnh hoặc dùng công cụ như jvisualvm để xem xét.

- Đầu tiên, hãy phỏng đoán lý do gây ra full GC thường xuyên. Nếu full GC diễn ra nhiều nhưng không xảy ra lỗi tràn bộ nhớ (OutOfMemoryError), điều đó có nghĩa là GC đang thu gom rất nhiều đối tượng. Cần đảm bảo các đối tượng này được thu gom trong young GC trước khi vào vùng cũ (old generation). Hãy thử tăng kích thước của vùng young generation. Nếu số lần full GC giảm, thì chỉnh sửa đã có hiệu quả.

- Có thể tìm ra luồng chiếm dụng CPU nhiều nhất, sau đó tối ưu hóa phương thức này để xem có thể tránh tạo ra một số đối tượng và tiết kiệm bộ nhớ hay không.

Đối với hệ thống đã xảy ra lỗi OutOfMemoryError (OOM):

- Thường hệ thống sản xuất được cấu hình để tạo file dump khi xảy ra lỗi OOM bằng các tham số: -XX:+HeapDumpOnOutOfMemoryError -XX:HeapDumpPath=/usr/local/base.

- Có thể dùng công cụ như jvisualvm để phân tích file dump.

- Tìm các đối tượng và luồng bất thường (luồng chiếm CPU cao) trong file dump để xác định mã gây ra vấn đề.

- Sau đó tiến hành phân tích và gỡ lỗi chi tiết.

Tóm lại, việc tối ưu hóa không thể thực hiện ngay lập tức mà cần có sự phân tích, suy luận, thử nghiệm, và đúc kết để tìm ra vấn đề chính.

Khi JVM gặp lỗi OOM có làm treo tiến trình không?

Khi một luồng thực thi, có khả năng cần tạo đối tượng mới, và việc tạo đối tượng đòi hỏi phải phân bổ bộ nhớ. Nếu JVM không đủ bộ nhớ, nó sẽ tiến hành thu gom rác (GC). Sau khi GC mà bộ nhớ vẫn không đủ, JVM sẽ ném ra ngoại lệ OutOfMemoryError. Nếu không bắt ngoại lệ này, luồng sẽ dừng lại giống như khi gặp bất kỳ ngoại lệ nào khác. Nếu bắt được OutOfMemoryError, luồng có thể sẽ không bị dừng lại. Tuy nhiên, việc luồng dừng lại hay không không liên quan trực tiếp đến việc tiến trình có bị dừng hay không. Khi tất cả các luồng không phải là daemon trong tiến trình dừng lại, thì tiến trình sẽ dừng. Hoặc nếu tiến trình chiếm quá nhiều bộ nhớ của hệ điều hành, nó có thể bị hệ điều hành đóng.

Quá trình một đối tượng từ khi được tải vào JVM đến khi bị GC xoá bỏ trải qua những giai đoạn gì?

- Đầu tiên, nội dung file bytecode được tải vào Method Area.

- Sau đó, dựa trên thông tin của lớp, đối tượng được tạo ra trong Heap.

- Đối tượng sẽ được phân bổ ở Eden Area của Young Generation trong Heap. Sau một lần Minor GC, nếu đối tượng vẫn tồn tại, nó sẽ được chuyển vào Survivor Area. Sau mỗi lần Minor GC, nếu đối tượng vẫn tồn tại, nó sẽ được sao chép qua lại giữa hai Survivor Area và tăng tuổi của đối tượng lên 1.

- Khi tuổi đối tượng vượt quá 15 và vẫn tồn tại, nó sẽ được chuyển vào Old Generation.

- Nếu sau Full GC, đối tượng bị đánh dấu là rác, nó sẽ bị luồng GC thu gom.

Làm thế nào để xác định một đối tượng có phải là rác hay không?

- Thuật toán đếm tham chiếu: Cách này ghi lại số lượng tham chiếu tới mỗi đối tượng trong Heap. Nếu số lượng tham chiếu bằng 0, đối tượng được coi là rác. Tuy nhiên, thuật toán này không thể giải quyết vấn đề vòng lặp tham chiếu.

- Thuật toán khả năng tiếp cận: Thuật toán này kiểm tra từ các đối tượng gốc (root) trong bộ nhớ và tìm các đối tượng có liên kết. Những đối tượng được tìm thấy không phải là rác, còn những đối tượng không được tìm thấy sẽ bị coi là rác.

Các thuật toán thu gom rác trong JVM?

Thuật toán đánh dấu và xoá (Mark-and-Sweep):

- Giai đoạn đánh dấu: Đánh dấu các vùng bộ nhớ không còn được sử dụng.

- Giai đoạn xoá: Giải phóng bộ nhớ được đánh dấu là rác.

- Nhược điểm của thuật toán này là gây ra phân mảnh bộ nhớ.

Thuật toán sao chép (Copying Algorithm): Chia bộ nhớ thành hai phần bằng nhau và chỉ sử dụng một phần. Khi thu gom rác, các đối tượng còn sống được sao chép sang phần còn lại và giải phóng toàn bộ bộ nhớ của phần đầu tiên. Cách này không gây phân mảnh nhưng lãng phí bộ nhớ.

Thuật toán đánh dấu và nén (Mark-Compact): Sau khi đánh dấu các đối tượng không sử dụng, thay vì giải phóng trực tiếp, thuật toán này di chuyển các đối tượng còn sống đến một đầu của bộ nhớ, sau đó giải phóng phần bộ nhớ không sử dụng.

STW là gì?

STW (Stop-The-World) là trạng thái trong quá trình thu gom rác, khi JVM tạm dừng tất cả các luồng (trừ các luồng GC). Trong trạng thái STW, các phương thức native có thể chạy nhưng không thể tương tác với JVM. Mục tiêu của các thuật toán tối ưu hóa GC là giảm thời gian STW, và đây cũng là trọng tâm của việc tối ưu hóa JVM.

Các tham số của JVM?

Tham số JVM có thể chia thành ba loại:

- Lệnh chuẩn: Bắt đầu bằng dấu "-". Các tham số này được hỗ trợ bởi tất cả các phiên bản HotSpot. Sử dụng lệnh

java -helpđể liệt kê. - Lệnh không chuẩn: Bắt đầu bằng "-X". Thường gắn liền với các phiên bản cụ thể của HotSpot. Sử dụng lệnh

java -Xđể xem. - Tham số không ổn định: Bắt đầu bằng "-XX". Những tham số này thay đổi nhiều giữa các phiên bản HotSpot.

Hiểu biết về an toàn luồng (thread safety)?

An toàn luồng đề cập đến việc khi một đoạn mã được thực thi bởi nhiều luồng đồng thời, không xảy ra tình trạng xung đột và kết quả vẫn chính xác. Ví dụ, khi một biến i được khởi tạo là 0, nếu hai luồng cùng thực thi câu lệnh i++, kết quả của một luồng phải là 1 và của luồng kia phải là 2. Nếu cả hai luồng đều cho kết quả là 1, điều đó cho thấy đoạn mã không an toàn luồng.

Vì vậy, an toàn luồng có nghĩa là một đoạn mã khi được nhiều luồng thực thi đồng thời vẫn đảm bảo cho kết quả đúng.

Hiểu biết về luồng daemon (luồng nền)

Luồng trong Java được chia thành hai loại: luồng người dùng và luồng daemon (luồng nền). Luồng người dùng là các luồng bình thường mà chúng ta tạo ra, còn luồng daemon là các luồng chạy ở chế độ nền của JVM, ví dụ như luồng xử lý rác (garbage collection). Luồng daemon sẽ tự động tắt khi tất cả các luồng người dùng đã kết thúc. Chúng ta có thể thiết lập một luồng trở thành luồng daemon bằng cách gọi thread.setDaemon(true).

Nguyên lý cơ bản của ThreadLocal

- ThreadLocal là một cơ chế lưu trữ dữ liệu riêng cho từng luồng trong Java, nó cho phép một luồng lưu trữ và truy cập dữ liệu tại bất kỳ thời điểm nào trong quá trình thực thi, mà không bị chia sẻ bởi các luồng khác.

- Ở tầng thấp, ThreadLocal được thực hiện thông qua một cấu trúc dữ liệu gọi là ThreadLocalMap. Mỗi đối tượng

Threadcó một bản sao riêng củaThreadLocalMap, trong đókeylà đối tượngThreadLocalvàvaluelà giá trị cần lưu trữ. - Sử dụng ThreadLocal trong các luồng của thread pool có thể gây ra rò rỉ bộ nhớ nếu không xóa các entry sau khi sử dụng. Để khắc phục, sau khi dùng xong

ThreadLocal, ta nên gọi phương thứcremoveđể giải phóng tài nguyên. - Một ví dụ phổ biến của ThreadLocal là trong quản lý kết nối, nơi mỗi luồng giữ một kết nối riêng biệt.

Sự khác biệt giữa đồng thời, song song và tuần tự

- Tuần tự: Các tác vụ được thực thi lần lượt, tác vụ này hoàn thành rồi mới đến tác vụ khác.

- Song song (Parallelism): Hai tác vụ được thực thi cùng lúc, trên hai luồng hoặc CPU khác nhau.

- Đồng thời (Concurrency): Hai tác vụ xuất hiện như đang thực thi cùng lúc, nhưng thực tế CPU chuyển đổi giữa các tác vụ rất nhanh.

Làm sao để tránh deadlock trong Java?

Deadlock xảy ra khi bốn điều kiện sau đều thỏa mãn:

- Tài nguyên chỉ được một luồng sử dụng tại một thời điểm.

- Luồng chờ tài nguyên không nhả các tài nguyên đã chiếm giữ.

- Tài nguyên không thể bị cưỡng chế lấy lại.

- Luồng hình thành mối quan hệ chờ tài nguyên theo chu kỳ.

Để tránh deadlock, chỉ cần vi phạm một trong bốn điều kiện trên, ví dụ:

- Thiết lập một thứ tự khóa cố định giữa các luồng.

- Thiết lập thời gian chờ khi khóa.

- Sử dụng cơ chế kiểm tra deadlock để phát hiện sớm.

Nguyên lý làm việc của thread pool

Thread pool kết hợp giữa hàng đợi và luồng. Khi thêm một tác vụ vào thread pool:

- Nếu số luồng hiện tại ít hơn

corePoolSize, tạo thêm luồng mới để xử lý. - Nếu đã đạt đến

corePoolSize, tác vụ được đưa vào hàng đợi. - Nếu hàng đợi đầy và số luồng ít hơn

maximumPoolSize, tạo thêm luồng mới. - Nếu số luồng đã đạt đến

maximumPoolSize, sử dụng chiến lược đã định để xử lý tác vụ (thường là từ chối tác vụ). - Khi số luồng vượt quá

corePoolSizevà luồng rảnh quá lâu, luồng sẽ bị hủy.

Tại sao thread pool thêm vào hàng đợi trước khi tạo luồng tối đa?

Khi các luồng đang bận, các tác vụ sẽ được đưa vào hàng đợi thay vì tạo thêm luồng ngay lập tức. Nếu hàng đợi đầy, mới bắt đầu tạo thêm luồng. Điều này tương tự như trong công ty: nếu có quá nhiều công việc, thay vì thuê thêm người ngay, công việc sẽ được đưa vào danh sách chờ để nhân viên hiện tại hoàn thành dần.

Sự khác biệt giữa khóa công bằng và thiên vị trong ReentrantLock

Khóa công bằng và thiên vị đều sử dụng AQS để quản lý hàng đợi, sự khác biệt là ở lúc lấy khóa:

- Khóa công bằng: Luồng sẽ kiểm tra hàng đợi, nếu có luồng đang chờ, nó sẽ xếp hàng.

- Khóa thiên vị: Luồng sẽ cố gắng giành khóa ngay mà không kiểm tra hàng đợi.

Dù khóa công bằng hay thiên vị, khi một luồng không giành được khóa, nó đều phải xếp hàng. Khi khóa được giải phóng, luồng ở đầu hàng sẽ được đánh thức.

Sự khác biệt giữa tryLock() và lock() trong ReentrantLock

- tryLock(): Cố gắng lấy khóa, nếu lấy được sẽ trả về

true, nếu không lấy được sẽ trả vềfalsemà không chặn luồng. - lock(): Chặn luồng cho đến khi lấy được khóa.

Sự khác biệt giữa CountDownLatch và Semaphore

- CountDownLatch: Một cơ chế đếm ngược. Một luồng chờ đợi khi giá trị đếm về 0, các luồng khác giảm giá trị đếm xuống. Khi giá trị đạt 0, tất cả các luồng chờ đợi sẽ được đánh thức.

- Semaphore: Một cơ chế quản lý tín hiệu. Cho phép một số lượng luồng nhất định chạy đồng thời. Khi một luồng giải phóng tín hiệu, một luồng khác trong hàng đợi sẽ được đánh thức.

Sychronized: Khóa thiên vị, khóa nhẹ, và khóa nặng

- Khóa thiên vị: Trong phần header của đối tượng khóa sẽ lưu lại ID của luồng hiện tại đang giữ khóa, nếu luồng đó yêu cầu khóa lại, nó có thể lấy khóa trực tiếp.

- Khóa nhẹ: Khi một luồng khác cạnh tranh để lấy khóa trong khi khóa đang ở trạng thái khóa thiên vị, khóa sẽ nâng cấp lên khóa nhẹ. Khóa nhẹ được thực hiện bằng cách quay vòng (spin), do đó không làm chặn luồng.

- Nếu số lần quay vòng quá nhiều mà vẫn không lấy được khóa, nó sẽ nâng cấp lên khóa nặng, khiến luồng bị chặn.

- Khóa quay vòng (spin lock): Khóa này không làm chặn luồng, thay vì đó, luồng sẽ quay vòng liên tục để thử lấy khóa bằng cách sử dụng lệnh CAS (Compare-And-Swap). Nếu khóa không được lấy, luồng tiếp tục quay vòng mà không bị hệ điều hành can thiệp vào việc chặn hoặc đánh thức luồng.

Sự khác biệt giữa Synchronized và ReentrantLock

- Synchronized là một từ khóa, còn ReentrantLock là một lớp.

- Synchronized tự động khóa và mở khóa, còn ReentrantLock yêu cầu lập trình viên phải khóa và mở khóa thủ công.

- Synchronized hoạt động ở mức JVM, còn ReentrantLock hoạt động ở mức API.

- Synchronized là khóa thiên vị, còn ReentrantLock có thể lựa chọn khóa công bằng hoặc thiên vị.

- Synchronized khóa đối tượng, thông tin về khóa được lưu trong phần đầu của đối tượng, trong khi ReentrantLock sử dụng một biến

statekiểuintđể xác định trạng thái khóa. - Synchronized có cơ chế nâng cấp khóa trong tầng thấp.

Hiểu biết về AQS và cách AQS thực hiện khóa tái nhập

- AQS (AbstractQueuedSynchronizer) là một khung đồng bộ hóa luồng trong Java, là phần cốt lõi của nhiều công cụ khóa trong JDK.

- AQS duy trì một biến tín hiệu

statevà một hàng đợi các luồng dưới dạng danh sách liên kết kép. Hàng đợi này dùng để xếp hàng cho các luồng, cònstatenhư một đèn tín hiệu, điều khiển việc luồng có được phép tiếp tục hay không. Tùy vào từng ngữ cảnh,statesẽ mang ý nghĩa khác nhau. - Trong trường hợp khóa tái nhập,

stateđược dùng để biểu thị số lần khóa. Khistatelà 0, nghĩa là không có khóa nào, mỗi lần khóa thành côngstatesẽ tăng lên 1, và khi mở khóa thìstatesẽ giảm đi 1.

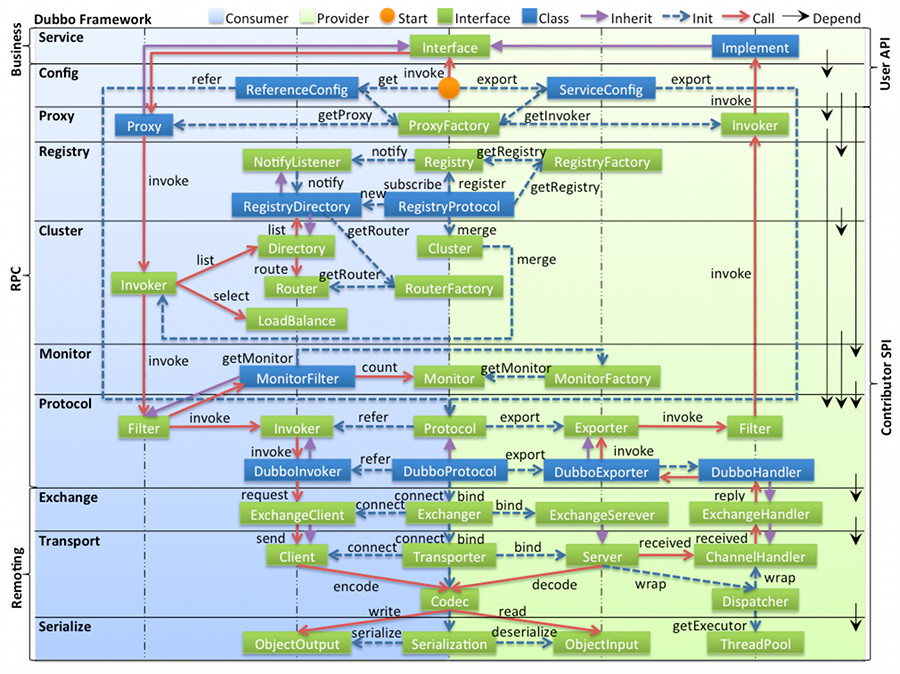

Hiểu biết về IoC

Thông thường, chúng ta biết rằng Spring có hai đặc điểm lớn là IoC và AOP. Vậy làm thế nào để hiểu được IoC (Inversion of Control - Đảo ngược quyền kiểm soát)?

Đối với nhiều người mới học, khái niệm IoC thường khiến họ cảm thấy "mình có vẻ hiểu nhưng lại không biết diễn đạt". Vậy IoC thực sự là gì? Đây là một vấn đề lớn, vì vậy chúng ta hãy chia nó thành những phần nhỏ hơn để trả lời. IoC là sự đảo ngược quyền kiểm soát, vậy:

- Điều gì đang được kiểm soát?

- Điều gì bị đảo ngược? Trước khi đảo ngược, ai kiểm soát? Sau khi đảo ngược, ai kiểm soát và kiểm soát bằng cách nào?

- Tại sao cần phải đảo ngược? Trước khi đảo ngược có vấn đề gì? Sau khi đảo ngược mang lại lợi ích gì?

Hãy bắt đầu với câu hỏi đầu tiên: Kiểm soát điều gì?

Khi sử dụng Spring, chúng ta cần làm những gì:

- Tạo một số lớp, ví dụ như

UserService,OrderService. - Sử dụng một số annotation như

@Autowired.

Chúng ta đều biết rằng, khi chương trình chạy, nó sử dụng các đối tượng cụ thể của UserService và OrderService. Những đối tượng này được tạo khi nào? Ai đã tạo ra chúng? Các thuộc tính bên trong đối tượng được gán giá trị khi nào? Ai đã gán giá trị? Tất cả những điều này không phải do lập trình viên làm, mà là do Spring thực hiện. Spring chính là người kiểm soát ngầm ở phía sau.

Kiểm soát bao gồm:

- Kiểm soát việc tạo đối tượng.

- Kiểm soát việc gán giá trị cho các thuộc tính của đối tượng.

Nếu không sử dụng Spring, chúng ta sẽ phải tự thực hiện những việc này. Ngược lại, khi sử dụng Spring, ta chỉ cần định nghĩa lớp và các thuộc tính cần được Spring gán giá trị (ví dụ, sử dụng @Autowired), đây chính là sự đảo ngược quyền kiểm soát.

Tại sao cần phải đảo ngược?

Nếu chúng ta tự tạo đối tượng và tự gán giá trị cho các thuộc tính, điều gì sẽ xảy ra? Ví dụ:

- Lớp A có thuộc tính

C c. - Lớp B cũng có thuộc tính

C c. - Lớp C là một lớp bình thường.

Chúng ta cần tạo đối tượng cho cả ba lớp và gán giá trị cho các thuộc tính:

A a = new A();B b = new B();C c = new C();a.c = c;b.c = c;

Những dòng mã này là những phần mà chúng ta phải viết thêm nếu không dùng Spring. Khi số lượng lớp tăng lên hoặc số thuộc tính trong mỗi lớp nhiều hơn, mã sẽ trở nên phức tạp và rắc rối hơn. Vì vậy, khi chúng ta để Spring kiểm soát, mã nguồn sẽ giảm đi và đơn giản hơn.

Tóm lại, IoC là sự đảo ngược quyền kiểm soát. Nếu sử dụng Spring, Spring sẽ chịu trách nhiệm tạo đối tượng và gán giá trị cho các thuộc tính của đối tượng.

Single Bean và Singleton

Singleton có nghĩa là trong JVM chỉ tồn tại duy nhất một đối tượng của một lớp nào đó.

Còn Single Bean không có nghĩa là trong JVM chỉ có duy nhất một đối tượng Bean của một lớp nào đó.

Cơ chế truyền tải giao dịch trong Spring

Khi nhiều phương thức giao dịch gọi lẫn nhau, giao dịch sẽ được truyền tải như thế nào giữa các phương thức này? Giả sử phương thức A là một phương thức giao dịch và trong quá trình thực thi, phương thức A gọi phương thức B. Khi đó, việc phương thức B có sử dụng giao dịch hay không và yêu cầu của phương thức B về giao dịch sẽ ảnh hưởng đến cách thức giao dịch của phương thức A được thực thi. Đồng thời, giao dịch của phương thức A cũng ảnh hưởng đến cách thức giao dịch của phương thức B. Những ảnh hưởng này được quyết định bởi loại hình truyền tải giao dịch của hai phương thức.

- REQUIRED (mặc định trong Spring): Nếu không có giao dịch hiện tại, tạo mới một giao dịch; nếu đang có giao dịch hiện tại, tham gia vào giao dịch đó.

- SUPPORTS: Nếu có giao dịch hiện tại, tham gia vào giao dịch đó; nếu không có giao dịch hiện tại, thực thi như một phương thức không có giao dịch.

- MANDATORY: Nếu có giao dịch hiện tại, tham gia vào giao dịch đó; nếu không có giao dịch hiện tại, ném ra ngoại lệ.

- REQUIRES_NEW: Tạo mới một giao dịch, nếu đang có giao dịch hiện tại thì tạm ngừng giao dịch đó.

- NOT_SUPPORTED: Thực thi như một phương thức không có giao dịch, nếu có giao dịch hiện tại thì tạm ngừng giao dịch đó.

- NEVER: Không sử dụng giao dịch, nếu có giao dịch hiện tại thì ném ra ngoại lệ.

- NESTED: Nếu có giao dịch hiện tại, thực thi trong một giao dịch lồng nhau; nếu không có giao dịch hiện tại, hoạt động giống như

REQUIRED(tạo mới một giao dịch).

Tám tình huống làm cho giao dịch trong Spring không hiệu quả và nguyên nhân phân tích

- Tự gọi trong phương thức: Giao dịch Spring dựa trên AOP. Khi một phương thức được gọi thông qua đối tượng proxy, giao dịch Spring mới có hiệu lực. Nhưng khi trong một phương thức gọi

this.xxx()để gọi phương thức khác,thiskhông phải là đối tượng proxy, dẫn đến giao dịch không có hiệu lực.- Giải pháp 1: Tách phương thức gọi sang một Bean khác.

- Giải pháp 2: Tự tiêm chính mình.

- Giải pháp 3: Sử dụng

AopContext.currentProxy()cùng với@EnableAspectJAutoProxy(exposeProxy = true).

- Phương thức là private: Giao dịch Spring dựa trên CGLIB để thực hiện AOP. Nếu phương thức trong lớp cha là

private, lớp con không thể ghi đè, và do đó không thể bổ sung logic giao dịch của Spring. - Phương thức là final: Lý do tương tự với phương thức private, vì lớp con không thể ghi đè phương thức final của lớp cha.

- Phương thức được gọi bởi một luồng riêng: Khi MyBatis hoặc JdbcTemplate thực thi SQL, nó lấy đối tượng kết nối cơ sở dữ liệu từ

ThreadLocal. Nếu luồng khởi tạo giao dịch và luồng thực thi SQL không cùng một luồng, kết nối cơ sở dữ liệu sẽ không được lấy đúng, dẫn đến MyBatis hoặc JdbcTemplate sẽ tự tạo kết nối mới, khiến giao dịch không được kiểm soát đúng cách. - Không thêm annotation

@Configuration: Nếu không thêm annotation này trong các cấu hình Spring truyền thống, có thể dẫn đến việc Spring không quản lý đúng các Bean và không lấy được kết nối cơ sở dữ liệu từThreadLocal. - Ngoại lệ bị nuốt mất: Nếu Spring không bắt được ngoại lệ, giao dịch sẽ không bị rollback. Mặc định, Spring sẽ bắt các ngoại lệ loại

RuntimeExceptionvàError. - Lớp không được Spring quản lý.

- Cơ sở dữ liệu không hỗ trợ giao dịch.

Các bước tạo Bean trong Spring

Quá trình tạo một Bean trong Spring gồm các bước sau:

- Suy đoán phương thức khởi tạo.

- Khởi tạo đối tượng.

- Tiêm thuộc tính, hay còn gọi là tiêm phụ thuộc.

- Xử lý các callback của Aware.

- Trước khi khởi tạo, xử lý annotation

@PostConstruct. - Khởi tạo, xử lý interface

InitializingBean. - Sau khi khởi tạo, tiến hành AOP.

Bean trong Spring có an toàn trong môi trường đa luồng không?

Spring không xử lý riêng vấn đề an toàn luồng cho các Bean. Vì vậy:

- Nếu Bean là không có trạng thái, nó sẽ an toàn trong môi trường đa luồng.

- Nếu Bean có trạng thái, nó không an toàn trong môi trường đa luồng.

Vấn đề Bean có an toàn trong môi trường đa luồng hay không không liên quan đến phạm vi của Bean, mà phụ thuộc vào trạng thái của chính Bean đó.

Sự khác biệt giữa ApplicationContext và BeanFactory

BeanFactory là một thành phần cốt lõi trong Spring, đóng vai trò như một nhà máy tạo và quản lý các Bean. ApplicationContext kế thừa BeanFactory, vì vậy nó có tất cả các chức năng của BeanFactory. Ngoài ra, ApplicationContext còn cung cấp các chức năng khác như quản lý biến môi trường hệ thống, quốc tế hóa, và phát sự kiện mà BeanFactory không có.

Spring giao dịch được thực hiện như thế nào

- Giao dịch trong Spring được xây dựng dựa trên giao dịch của cơ sở dữ liệu và cơ chế AOP.

- Đối với các Bean có sử dụng annotation

@Transactional, Spring sẽ tạo một đối tượng proxy cho Bean đó. - Khi gọi phương thức của đối tượng proxy, Spring sẽ kiểm tra xem phương thức đó có annotation

@Transactionalhay không. - Nếu có, Spring sẽ sử dụng bộ quản lý giao dịch để tạo một kết nối cơ sở dữ liệu.

- Đồng thời, thay đổi thuộc tính

autocommitcủa kết nối thànhfalseđể ngăn việc tự động commit. Đây là bước rất quan trọng để thực hiện giao dịch trong Spring. - Sau đó, phương thức hiện tại sẽ được thực thi, bao gồm cả các câu lệnh SQL.

- Sau khi phương thức được thực thi, nếu không xảy ra ngoại lệ, giao dịch sẽ được commit.

- Nếu có ngoại lệ và ngoại lệ này yêu cầu rollback, giao dịch sẽ được rollback. Nếu ngoại lệ không yêu cầu rollback, giao dịch vẫn sẽ được commit.

- Mức độ cách ly của giao dịch Spring tương ứng với mức độ cách ly của cơ sở dữ liệu.

- Cơ chế truyền tải giao dịch là phần phức tạp nhất của Spring và được thực hiện dựa trên các kết nối cơ sở dữ liệu. Mỗi kết nối tương ứng với một giao dịch. Nếu cơ chế truyền tải yêu cầu mở một giao dịch mới, Spring sẽ tạo một kết nối mới và thực thi SQL trên kết nối đó.

Khi nào annotation @Transactional trong Spring không có hiệu lực

Vì giao dịch trong Spring được thực hiện dựa trên các proxy, nên một phương thức có annotation @Transactional chỉ có hiệu lực khi nó được gọi thông qua đối tượng proxy. Nếu phương thức được gọi không thông qua đối tượng proxy, annotation @Transactional sẽ không có hiệu lực.

Ngoài ra, nếu phương thức là private, thì @Transactional cũng sẽ không có hiệu lực. Điều này là do CGLIB, một công cụ tạo proxy của Spring, dựa trên mối quan hệ cha-con. Các phương thức private của lớp cha không thể bị ghi đè bởi lớp con, do đó không thể sử dụng proxy, dẫn đến annotation @Transactional không có hiệu lực.

Quy trình khởi động của Spring

- Khi tạo Spring container (khởi động Spring):

- Trước hết, Spring sẽ quét để tìm tất cả các đối tượng

BeanDefinitionvà lưu trữ chúng trong một Map. - Sau đó, Spring sẽ tạo các Bean đơn nhất (non-lazy) từ các

BeanDefinition. Các Bean có phạm vi nhiều hơn sẽ không được tạo trong quá trình khởi động, mà sẽ được tạo mỗi khi Bean đó được yêu cầu. - Việc tạo Bean từ

BeanDefinitionlà quá trình vòng đời của Bean. Nó bao gồm các bước như hợp nhấtBeanDefinition, suy đoán phương thức khởi tạo, khởi tạo đối tượng, tiêm thuộc tính, trước khi khởi tạo, khởi tạo và sau khi khởi tạo. AOP sẽ xảy ra ở bước sau khi khởi tạo. - Sau khi tạo tất cả các Bean đơn nhất, Spring sẽ phát ra một sự kiện khởi động container.

- Kết thúc quá trình khởi động Spring.

- Trong mã nguồn của Spring, quá trình này phức tạp hơn, bao gồm các phương thức mẫu cho các lớp con thực hiện. Ngoài ra, mã nguồn còn xử lý đăng ký

BeanFactoryPostProcessorvàBeanPostProcessor. Quá trình quét của Spring dựa vàoBeanFactoryPostProcessorvà việc tiêm phụ thuộc dựa vàoBeanPostProcessor. - Trong quá trình khởi động, Spring cũng sẽ xử lý các annotation như

@Import.

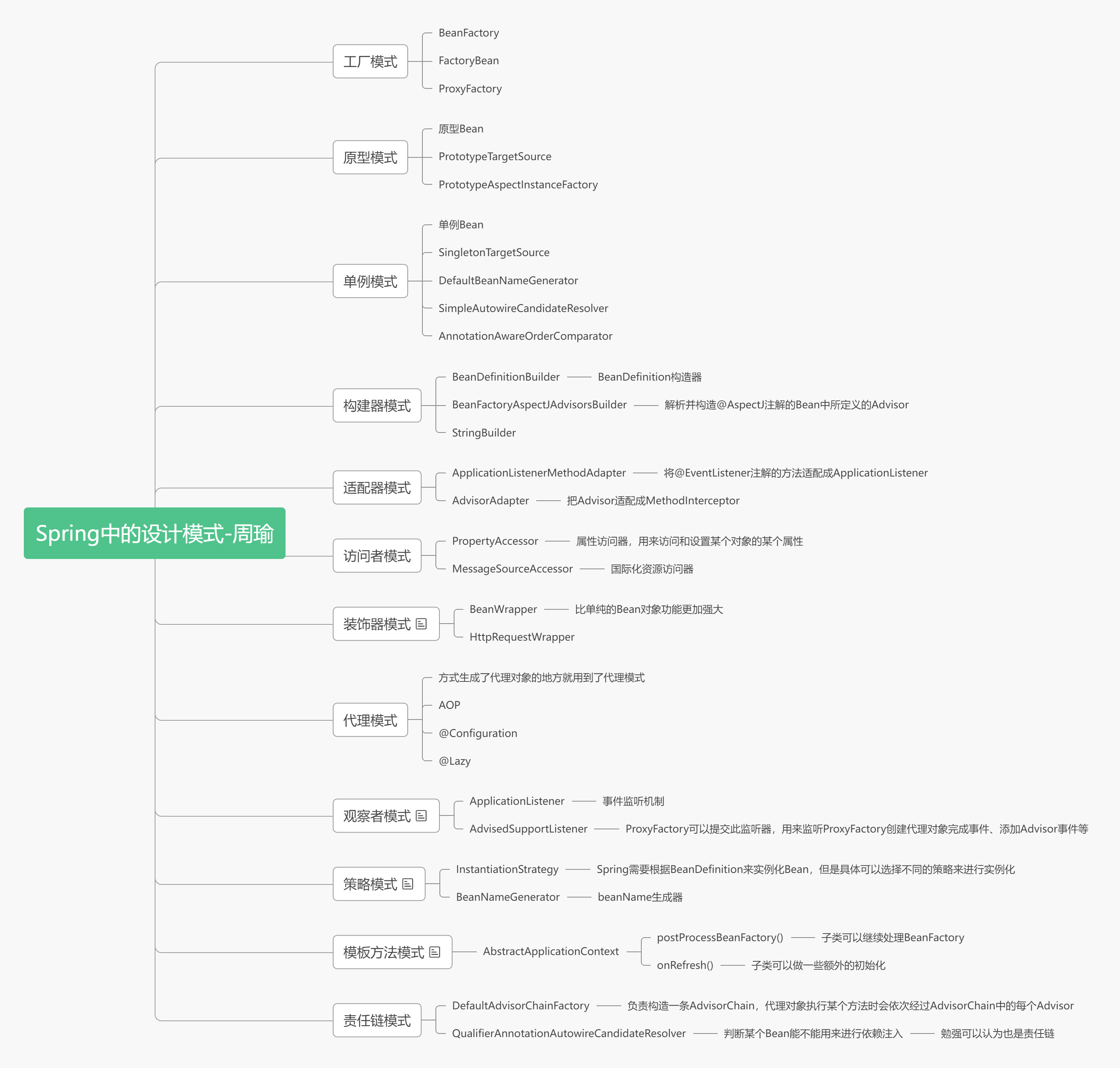

Các mẫu thiết kế được sử dụng trong Spring

Các annotation thường dùng trong Spring Boot và cách thức hoạt động

@SpringBootApplication: annotation này đánh dấu một ứng dụng Spring Boot, thực chất là tổ hợp của ba annotation:

- @SpringBootConfiguration: annotation này tương đương với

@Configuration, biểu thị rằng lớp khởi động cũng là một lớp cấu hình. - @EnableAutoConfiguration: Tự động tải các cấu hình được xác định trong

SpringFactoriesdướiClassPathvào Spring container dưới dạng các Bean cấu hình. - @ComponentScan: Xác định đường dẫn để quét các thành phần, mặc định quét đường dẫn của lớp khởi động.

- @SpringBootConfiguration: annotation này tương đương với

@Bean: Dùng để định nghĩa một Bean, tương tự như thẻ

<bean>trong XML. Khi Spring khởi động, nó sẽ phân tích các phương thức có annotation@Bean, sử dụng tên phương thức làm tên Bean và thực thi phương thức để tạo đối tượng Bean.Các annotation như

@Controller,@Service,@ResponseBody,@Autowiredcũng có thể được sử dụng.

Cách Spring Boot khởi động Tomcat

- Trước hết, khi Spring Boot khởi động, nó sẽ tạo một Spring container.

- Trong quá trình tạo Spring container, Spring Boot sẽ kiểm tra xem có tồn tại thư viện Tomcat trong

classpathhay không bằng cách sử dụng kỹ thuật@ConditionalOnClass. Nếu có, Spring Boot sẽ tạo một Bean khởi động Tomcat. - Sau khi Spring container được tạo, Spring Boot sẽ lấy Bean khởi động Tomcat, tạo một đối tượng Tomcat, cấu hình các cổng kết nối, và khởi động Tomcat.

Ưu điểm và nhược điểm của MyBatis

Ưu điểm:

- Dựa trên các câu lệnh SQL, linh hoạt và không gây ảnh hưởng đến thiết kế của ứng dụng hoặc cơ sở dữ liệu. SQL được viết trong XML, giúp tách biệt giữa SQL và mã chương trình, dễ dàng quản lý. Hỗ trợ viết SQL động và có thể tái sử dụng.

- Giảm hơn 50% lượng mã so với JDBC, loại bỏ các mã dư thừa trong JDBC và không cần tự tay mở/đóng kết nối.

- Tương thích tốt với nhiều cơ sở dữ liệu (MyBatis sử dụng JDBC để kết nối cơ sở dữ liệu, nên hỗ trợ mọi cơ sở dữ liệu mà JDBC hỗ trợ).

- Tích hợp tốt với Spring.

- Cung cấp các thẻ ánh xạ hỗ trợ ORM, ánh xạ giữa các trường trong cơ sở dữ liệu và đối tượng.

Nhược điểm:

- Lượng công việc viết SQL lớn, đặc biệt là khi có nhiều trường hoặc bảng liên kết. Yêu cầu lập trình viên có kỹ năng viết SQL tốt.

- SQL phụ thuộc vào cơ sở dữ liệu, gây khó khăn trong việc di chuyển cơ sở dữ liệu.

Sự khác biệt giữa #{} và ${} trong MyBatis

#{}là xử lý trước biên dịch và đóng vai trò như một dấu chỗ.${}là thay thế chuỗi và đóng vai trò như một chuỗi kết nối.

Khi MyBatis xử lý #{}, nó sẽ thay thế giá trị trong SQL bằng dấu ? và sử dụng PreparedStatement để gán giá trị.

Khi MyBatis xử lý ${}, nó sẽ thay thế giá trị bằng chuỗi trực tiếp trong SQL và sử dụng Statement để thực thi.

Sử dụng #{} có thể giúp ngăn ngừa tấn công SQL injection, nâng cao độ bảo mật của hệ thống.

Nguyên lý cơ bản của chỉ mục (Index)

Chỉ mục được sử dụng để tìm kiếm nhanh chóng các bản ghi có giá trị cụ thể. Nếu không có chỉ mục, thông thường khi thực hiện truy vấn sẽ phải duyệt toàn bộ bảng.

Nguyên lý của chỉ mục: Biến dữ liệu không có trật tự thành dữ liệu có trật tự để truy vấn.

- Sắp xếp nội dung của các cột đã tạo chỉ mục.

- Tạo bảng đảo ngược từ kết quả đã sắp xếp.

- Gắn kết địa chỉ dữ liệu vào nội dung của bảng đảo ngược.

- Khi truy vấn, đầu tiên lấy nội dung của bảng đảo ngược, sau đó lấy ra địa chỉ dữ liệu để lấy dữ liệu cụ thể.

Nguyên tắc thiết kế chỉ mục

Chỉ mục cần truy vấn nhanh hơn và chiếm ít không gian hơn.

- Các cột phù hợp để chỉ mục thường là những cột xuất hiện trong mệnh đề WHERE hoặc được chỉ định trong mệnh đề JOIN.

- Các bảng có cơ sở dữ liệu nhỏ sẽ cho hiệu quả chỉ mục kém, không cần thiết phải tạo chỉ mục cho cột này.

- Sử dụng chỉ mục ngắn. Nếu chỉ mục cho các cột chuỗi dài, nên chỉ định một độ dài tiền tố để tiết kiệm không gian chỉ mục. Nếu từ tìm kiếm vượt quá độ dài tiền tố của chỉ mục, sử dụng chỉ mục để loại trừ các dòng không phù hợp, sau đó kiểm tra các dòng còn lại có thể khớp hay không.

- Không nên tạo chỉ mục quá mức. Chỉ mục cần thêm không gian đĩa và làm giảm hiệu suất của các thao tác ghi. Khi sửa đổi nội dung bảng, chỉ mục sẽ được cập nhật hoặc thậm chí tái cấu trúc, thời gian này sẽ kéo dài hơn nếu có nhiều cột chỉ mục. Do đó, chỉ cần giữ lại các chỉ mục cần thiết cho việc truy vấn.

- Các cột dữ liệu được định nghĩa có khóa ngoại nhất định phải tạo chỉ mục.

- Các cột có tần suất cập nhật cao không phù hợp để tạo chỉ mục.

- Các cột không thể phân biệt hiệu quả dữ liệu không phù hợp làm cột chỉ mục (ví dụ như giới tính, có thể chỉ có ba loại: nam, nữ, chưa xác định, độ phân biệt quá thấp).

- Nên mở rộng chỉ mục hiện có thay vì tạo chỉ mục mới. Ví dụ: nếu bảng đã có chỉ mục cho a và giờ cần thêm chỉ mục cho (a, b), chỉ cần chỉnh sửa chỉ mục hiện tại.

- Đối với các cột ít được truy vấn hoặc có nhiều giá trị trùng lặp, không nên tạo chỉ mục.

- Không nên tạo chỉ mục cho các cột có kiểu dữ liệu được định nghĩa là text, image và bit.

Các đặc tính cơ bản của giao dịch và mức độ cách ly

Các đặc tính cơ bản của giao dịch (ACID) bao gồm:

Tính nguyên tử: Trong một giao dịch, các thao tác phải thành công hoàn toàn hoặc thất bại hoàn toàn.

Tính nhất quán: Cơ sở dữ liệu luôn chuyển từ một trạng thái nhất quán sang một trạng thái nhất quán khác. Ví dụ, nếu A chuyển cho B 100 đồng và giả sử A chỉ có 90 đồng, trước khi thanh toán, dữ liệu trong cơ sở dữ liệu phải tuân theo các ràng buộc. Nếu giao dịch thành công, dữ liệu trong cơ sở dữ liệu sẽ vi phạm các ràng buộc, vì vậy giao dịch không thể thành công. Tại đây, chúng ta nói rằng giao dịch cung cấp đảm bảo tính nhất quán.

Tính cách ly: Các thay đổi của một giao dịch không thể nhìn thấy bởi các giao dịch khác trước khi nó được xác nhận.

Tính bền vững: Khi một giao dịch đã được xác nhận, các thay đổi sẽ được lưu trữ vĩnh viễn trong cơ sở dữ liệu.

Tính cách ly có bốn mức độ, bao gồm:

Read uncommitted (Đọc chưa xác nhận): Có thể đọc dữ liệu chưa được xác nhận từ các giao dịch khác, còn gọi là đọc bẩn. Người dùng đáng lẽ phải đọc được tuổi của người dùng với id=1 là 10, nhưng lại đọc được tuổi từ một giao dịch khác chưa được xác nhận, kết quả là tuổi=20, đây là trường hợp đọc bẩn.

Read committed (Đọc đã xác nhận): Hai lần đọc kết quả không nhất quán, gọi là đọc không lặp lại. Đọc đã xác nhận giải quyết vấn đề đọc bẩn, chỉ đọc các giao dịch đã xác nhận. Người dùng mở giao dịch đọc người dùng với id=1, phát hiện tuổi=10, nhưng khi đọc lại thấy kết quả là 20. Trong cùng một giao dịch, cùng một truy vấn đọc được các kết quả khác nhau gọi là đọc không lặp lại.

Repeatable read (Đọc có thể lặp lại): Đây là mức độ mặc định của MySQL, mỗi lần đọc kết quả đều giống nhau, nhưng có thể phát sinh vấn đề đọc ma.

Serializable (Tuần tự): Thường không được sử dụng, vì nó sẽ khóa từng dòng dữ liệu được đọc, dẫn đến nhiều vấn đề về thời gian chờ và cạnh tranh khóa.

MVCC là gì?

MVCC (Multi-Version Concurrency Control - Kiểm soát đồng thời đa phiên bản) đề cập đến quá trình truy cập chuỗi phiên bản của các bản ghi khi thực hiện các thao tác SELECT thông thường trong các giao dịch sử dụng mức độ cách ly READ COMMITTED và REPEATABLE READ. Điều này cho phép các thao tác đọc-ghi và ghi-đọc của các giao dịch khác nhau thực hiện đồng thời, từ đó nâng cao hiệu suất hệ thống. Một điểm khác biệt lớn giữa hai mức độ cách ly READ COMMITTED và REPEATABLE READ là: thời điểm tạo ReadView khác nhau. READ COMMITTED sẽ tạo một ReadView trước mỗi lần thực hiện thao tác SELECT thông thường, trong khi REPEATABLE READ chỉ tạo một ReadView trước lần thực hiện SELECT đầu tiên, và sau đó các thao tác truy vấn sau sẽ tái sử dụng ReadView này.

Tóm tắt sự khác biệt giữa MyISAM và InnoDB

MyISAM:

- Không hỗ trợ giao dịch, nhưng mỗi lần truy vấn đều là nguyên tử.

- Hỗ trợ khóa cấp bảng, tức là mỗi thao tác đều khóa toàn bộ bảng.

- Lưu trữ tổng số hàng của bảng.

- Một bảng MYISAM có ba tệp: tệp chỉ mục, tệp cấu trúc bảng và tệp dữ liệu.

- Sử dụng chỉ mục không tập trung, trong đó miền dữ liệu của tệp chỉ mục lưu trữ các con trỏ chỉ vào tệp dữ liệu. Chỉ mục phụ gần như giống với chỉ mục chính, nhưng chỉ mục phụ không cần đảm bảo tính duy nhất.

InnoDB:

- Hỗ trợ giao dịch ACID, hỗ trợ bốn mức độ cách ly của giao dịch.

- Hỗ trợ khóa cấp hàng và ràng buộc khóa ngoại, do đó có thể hỗ trợ ghi đồng thời.

- Không lưu trữ tổng số hàng.

- Một động cơ InnoDB lưu trữ trong một không gian tệp (không gian bảng chia sẻ, kích thước bảng không bị hệ điều hành kiểm soát, một bảng có thể phân bố trên nhiều tệp), cũng có thể là nhiều không gian (được đặt thành không gian bảng độc lập, kích thước bảng bị giới hạn bởi kích thước tệp của hệ điều hành, thường là 2G), phụ thuộc vào giới hạn kích thước tệp của hệ điều hành.

- Chỉ mục khóa chính sử dụng chỉ mục tập trung (miền dữ liệu của chỉ mục lưu trữ chính tệp dữ liệu), miền dữ liệu của chỉ mục phụ lưu trữ giá trị khóa chính; vì vậy, để tìm dữ liệu qua chỉ mục phụ, cần phải tìm giá trị khóa chính qua chỉ mục phụ trước, rồi truy cập chỉ mục phụ; tốt nhất là sử dụng khóa chính tự tăng để tránh phải điều chỉnh lớn tệp khi chèn dữ liệu, nhằm duy trì cấu trúc B+ cây.

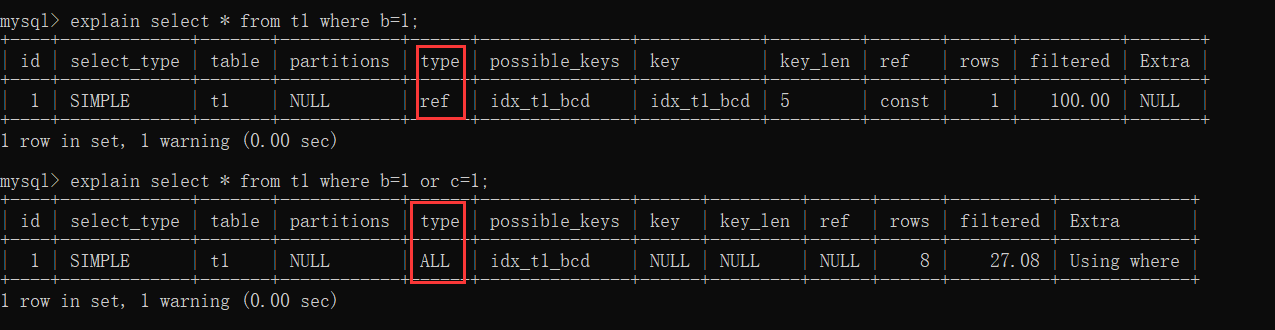

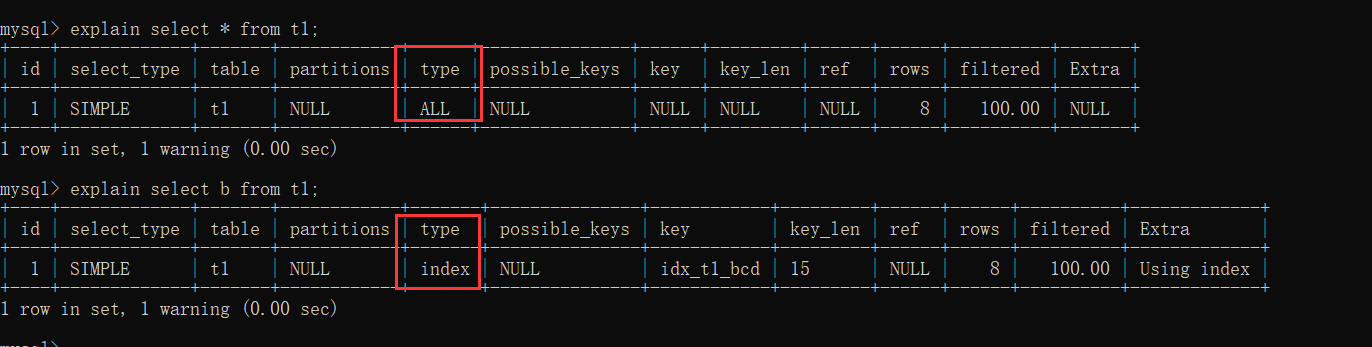

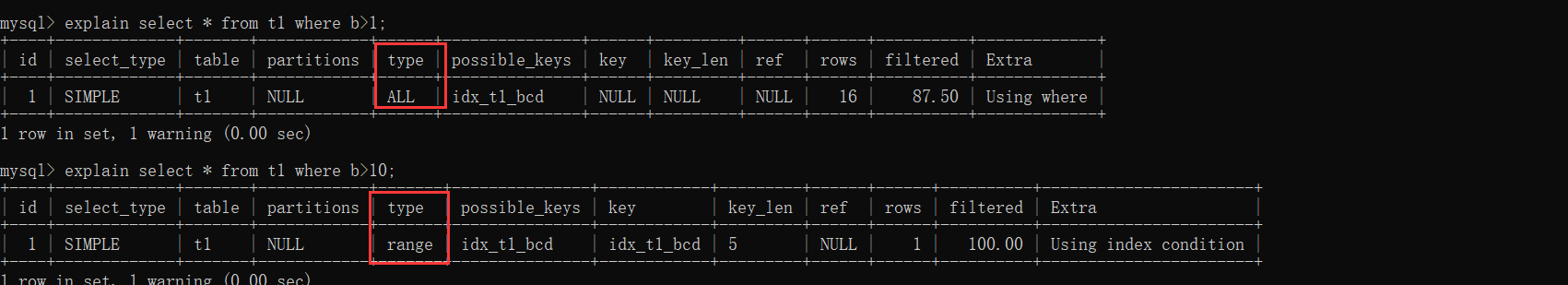

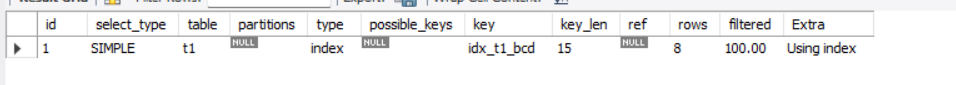

Các trường trong kết quả của câu lệnh Explain đại diện cho điều gì

| Tên cột | Mô tả |

|---|---|

| id | Mỗi khi xuất hiện một từ khóa SELECT trong câu truy vấn, MySQL sẽ gán một giá trị id duy nhất cho nó. Một số truy vấn con có thể được tối ưu thành truy vấn JOIN, do đó id xuất hiện sẽ giống nhau. |

| select_type | Loại truy vấn tương ứng với từ khóa SELECT. |

| table | Tên bảng. |

| partitions | Thông tin về các phân vùng phù hợp. |

| type | Phương thức truy vấn đối với bảng đơn (quét toàn bộ bảng, chỉ mục). |

| possible_keys | Các chỉ mục có thể được sử dụng. |

| key | Chỉ mục thực tế đã sử dụng. |

| key_len | Độ dài của chỉ mục thực tế đã sử dụng. |

| ref | Thông tin về đối tượng được khớp với cột chỉ mục khi sử dụng truy vấn với giá trị bằng. |

| rows | Số lượng bản ghi dự đoán cần đọc. |

| filtered | Tỷ lệ phần trăm số bản ghi còn lại sau khi bảng được lọc qua điều kiện tìm kiếm. |

| Extra | Một số thông tin bổ sung, chẳng hạn như sắp xếp, v.v. |

Phân tích chín tình huống làm mất hiệu lực của chỉ mục trong MySQL

Dữ liệu bảng:

CREATE TABLE `t1` (

a int primary key,

b int,

c int,

d int,

e varchar(20)

) ENGINE=InnoDB;

insert into t1 values(4,3,1,1,'d');

insert into t1 values(1,1,1,1,'a');

insert into t1 values(8,8,8,8,'h');

insert into t1 values(2,2,2,2,'b');

insert into t1 values(5,2,3,5,'e');

insert into t1 values(3,3,2,2,'c');

insert into t1 values(7,4,5,5,'g');

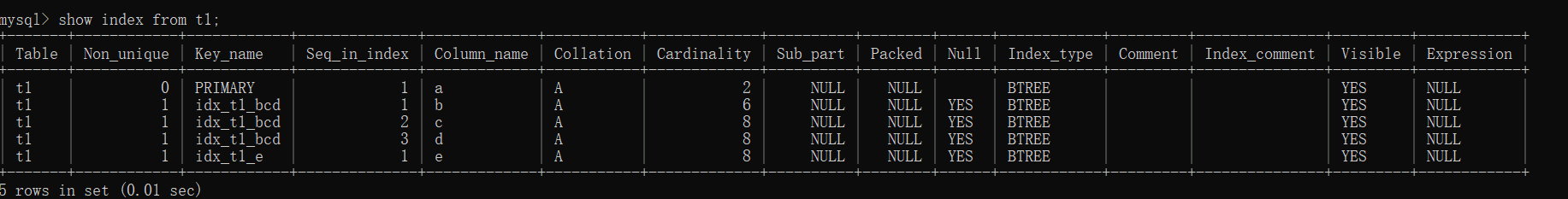

insert into t1 values(6,6,4,4,'f');Tình trạng chỉ mục:

Trường a là khóa chính, tương ứng với chỉ mục khóa chính, ba trường b, c, d tạo thành một chỉ mục kết hợp, và trường e có một chỉ mục.

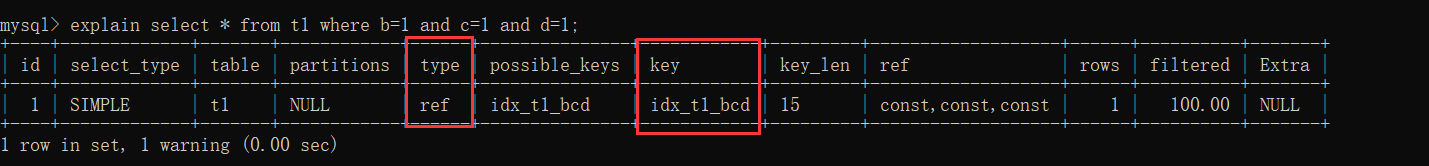

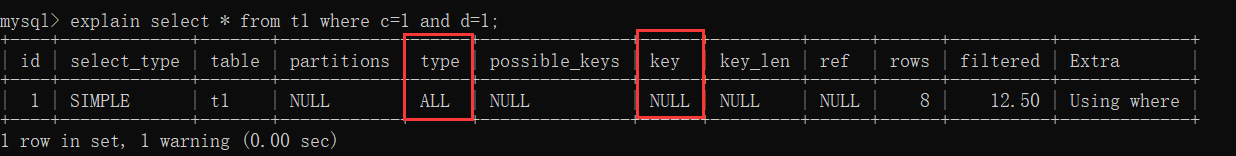

1. Không tuân thủ nguyên tắc khớp trái nhất

Khi bỏ điều kiện b=1, sẽ không tuân thủ nguyên tắc khớp trái nhất, dẫn đến tất cả đều bị mất hiệu lực.

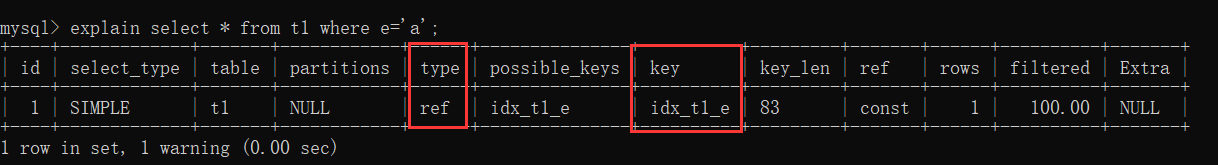

2. Truy vấn Like không chính xác

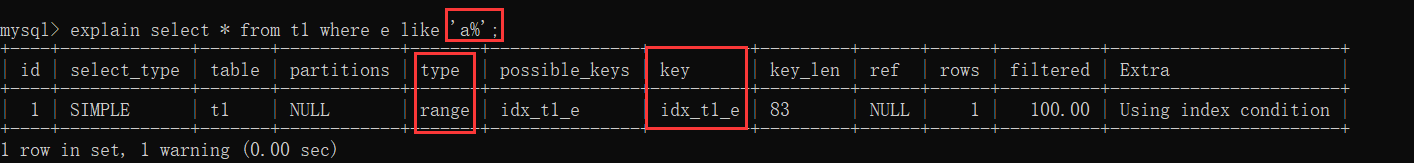

Không sử dụng like có thể sử dụng chỉ mục:

Sử dụng like đúng cách:

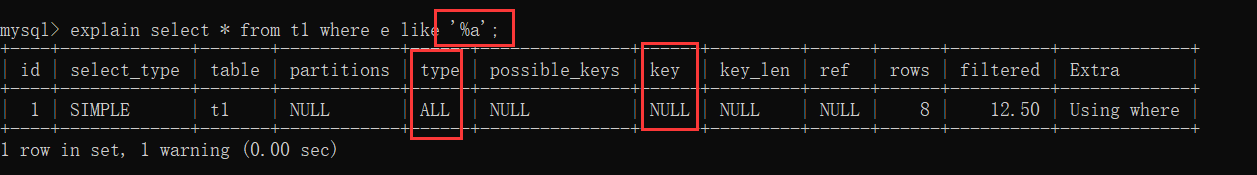

Sử dụng like không đúng cách:

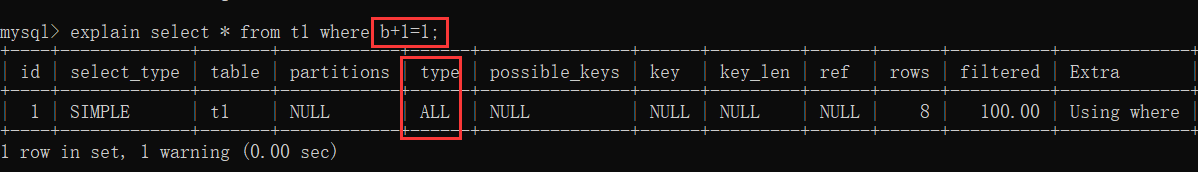

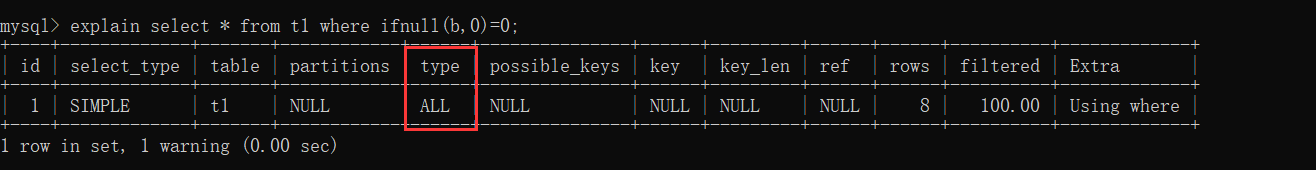

3. Thực hiện phép tính trên cột chỉ mục hoặc sử dụng hàm

4. Chuyển đổi kiểu trên cột chỉ mục

Trường e có kiểu là varchar, câu SQL dưới đây cần chuyển đổi ký tự trong trường e thành số, điều này sẽ làm mất hiệu lực của chỉ mục.

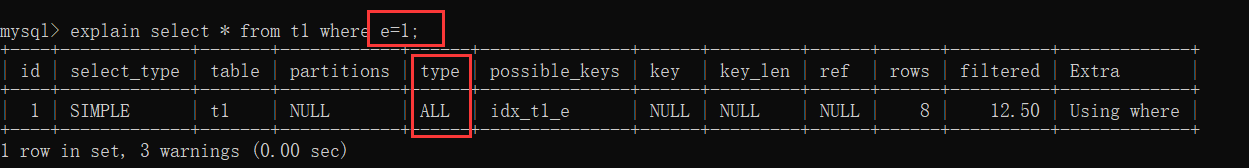

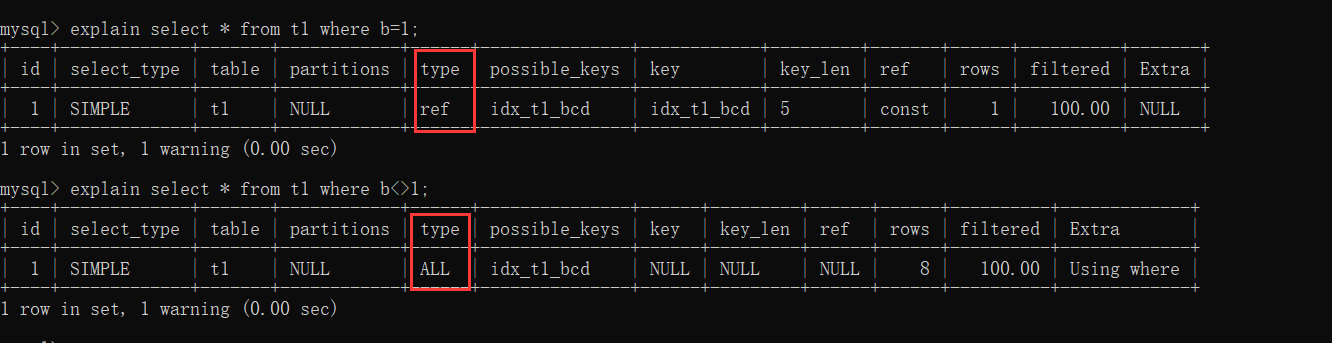

5. <> không bằng gây mất hiệu lực chỉ mục

b=1 có thể sử dụng chỉ mục, nhưng b<>1 thì không.

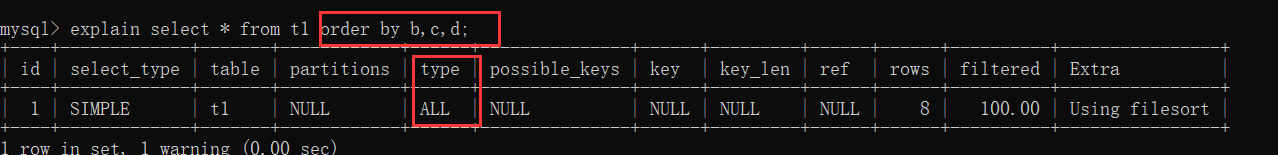

6. order by gây mất hiệu lực chỉ mục

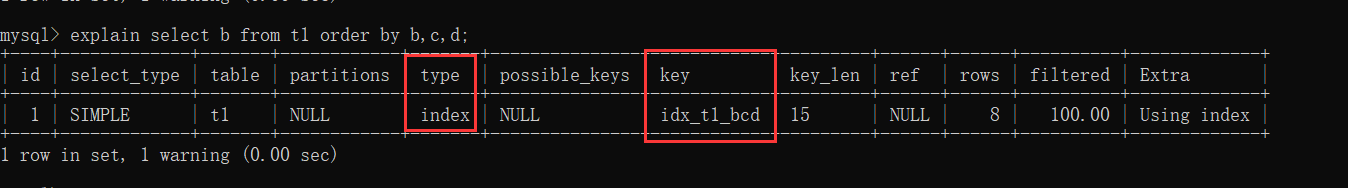

Dù có sử dụng chỉ mục, nhưng do là select * nên cần phải truy vấn lại bảng, và chi phí truy vấn lại khá cao, vì vậy sẽ không sử dụng chỉ mục.

Nếu là select b thì cần phải truy vấn lại bảng, và sẽ chọn sử dụng chỉ mục.

7. Sử dụng or gây mất hiệu lực chỉ mục

8. select * gây mất hiệu lực chỉ mục

9. Truy vấn phạm vi với khối lượng dữ liệu quá lớn dẫn đến mất hiệu lực chỉ mục

Thêm một số dữ liệu mới:

insert into t1 values(10,3,1,1,'d');

insert into t1 values(20,1,1,1,'a');

insert into t1 values(15,8,8,8,'h');

insert into t1 values(18,2,2,2,'b');

insert into t1 values(14,2,3,5,'e');

insert into t1 values(13,3,2,2,'c');

insert into t1 values(17,4,5,5,'g');

insert into t1 values(22,6,4,4,'f');

Chỉ mục bao phủ là gì?

Chỉ mục bao phủ là khi một câu SQL trong quá trình thực thi có thể sử dụng chỉ mục để tìm kiếm nhanh chóng, và các trường cần truy vấn của câu SQL này đều có trong các trường tương ứng của chỉ mục hiện tại. Điều này có nghĩa là sau khi câu SQL thực hiện xong chỉ mục, nó không cần phải quay lại bảng nữa, vì các trường cần thiết đã có sẵn trên các nút lá của chỉ mục hiện tại và có thể được trả về trực tiếp như kết quả.

Nguyên tắc tiền tố trái nhất là gì?

Khi một câu SQL muốn sử dụng chỉ mục, nó nhất định phải cung cấp trường ở bên trái nhất trong các trường tương ứng của chỉ mục, tức là trường đứng đầu tiên. Ví dụ, nếu một chỉ mục kết hợp được tạo cho các trường a, b, c, thì khi viết một câu SQL, điều kiện cho trường a nhất định phải được cung cấp. Điều này đảm bảo rằng chỉ mục kết hợp được sử dụng, vì khi tạo chỉ mục kết hợp cho các trường a, b, c, cây B+ cơ sở sẽ được sắp xếp theo thứ tự từ trái sang phải dựa trên a, b, c. Do đó, nếu muốn sử dụng cây B+ để tìm kiếm nhanh chóng, phải tuân theo quy tắc này.

Innodb thực hiện giao dịch như thế nào?

Innodb sử dụng Buffer Pool, LogBuffer, Redo Log, và Undo Log để thực hiện giao dịch. Ví dụ với một câu lệnh update:

- Khi Innodb nhận được một câu lệnh update, nó sẽ tìm trang dữ liệu theo điều kiện và lưu trang đó vào Buffer Pool.

- Thực hiện câu lệnh update, sửa đổi dữ liệu trong Buffer Pool, tức là dữ liệu trong bộ nhớ.

- Tạo một đối tượng RedoLog cho câu lệnh update và lưu vào LogBuffer.

- Tạo một bản ghi undolog cho câu lệnh update, dùng để hoàn tác giao dịch.

- Nếu giao dịch được xác nhận, đối tượng RedoLog sẽ được lưu trữ vĩnh viễn; sau đó, còn có các cơ chế khác để lưu các trang dữ liệu đã chỉnh sửa trong Buffer Pool vào đĩa.

- Nếu giao dịch bị hoàn tác, sẽ sử dụng bản ghi undolog để quay lại.

Sự khác biệt giữa B-tree và B+ tree, tại sao MySQL lại sử dụng B+ tree?

Đặc điểm của B-tree:

- Các nút được sắp xếp.

- Một nút có thể chứa nhiều phần tử, và các phần tử đó cũng được sắp xếp.

Đặc điểm của B+ tree:

- Có các đặc điểm của B-tree.

- Các nút lá có liên kết với nhau bằng con trỏ.

- Các phần tử trên nút không phải là nút đều được lưu trữ trên các nút lá, tức là tất cả các phần tử đều được lưu trữ trong các nút lá và được sắp xếp.

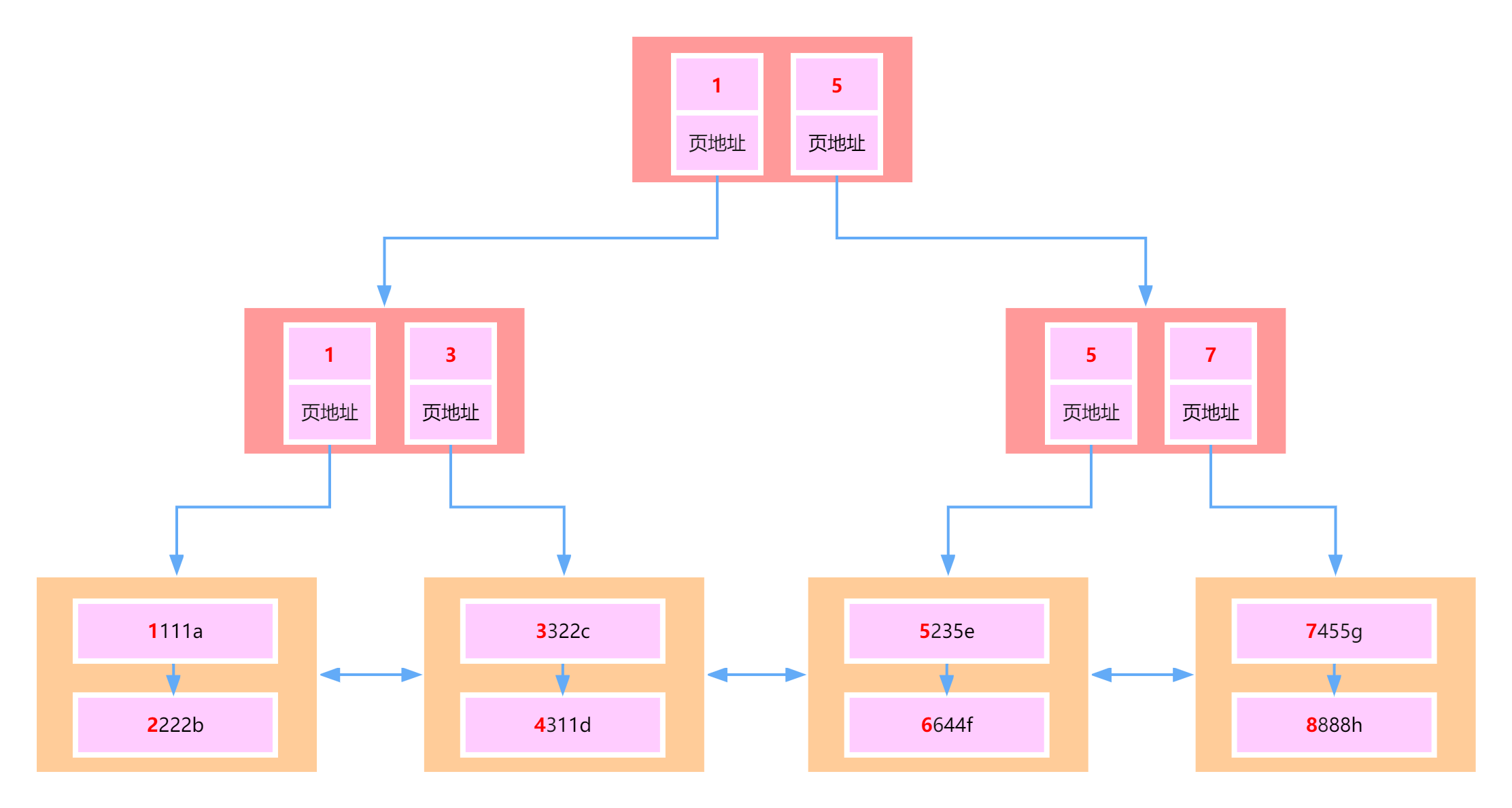

MySQL sử dụng B+ tree cho chỉ mục, vì chỉ mục được dùng để tăng tốc độ truy vấn, và B+ tree có thể tăng tốc độ truy vấn bằng cách sắp xếp dữ liệu. Hơn nữa, một nút có thể chứa nhiều phần tử, giúp chiều cao của B+ tree không quá lớn. Trong MySQL, một trang Innodb chính là một nút B+ tree, với kích thước mặc định là 16KB. Do đó, trong trường hợp thông thường, một B+ tree có hai tầng có thể chứa khoảng 20 triệu hàng dữ liệu. Bằng cách sử dụng các nút lá của B+ tree để lưu trữ tất cả dữ liệu và sắp xếp chúng, cũng như có các con trỏ giữa các nút lá, có thể hỗ trợ tốt cho việc quét toàn bộ bảng và các truy vấn tìm kiếm theo phạm vi.

Các loại khóa trong MySQL và cách hiểu

Phân loại theo độ chi tiết của khóa:

- Khóa hàng: Khóa một hàng dữ liệu, có độ chi tiết nhỏ nhất, cho phép đồng thời cao.

- Khóa bảng: Khóa toàn bộ bảng, có độ chi tiết lớn nhất, cho phép đồng thời thấp.

- Khóa khoảng: Khóa một khoảng dữ liệu.

Có thể phân loại thêm:

- Khóa chia sẻ: Còn gọi là khóa đọc, một giao dịch khóa một hàng dữ liệu cho phép các giao dịch khác có thể đọc, nhưng không được ghi.

- Khóa độc quyền: Còn gọi là khóa ghi, một giao dịch khóa một hàng dữ liệu khiến các giao dịch khác không thể đọc hay ghi.

Có thể phân loại thêm:

- Khóa lạc quan: Không thực sự khóa một hàng ghi nào mà thực hiện qua một số phiên bản.

- Khóa bi quan: Các khóa hàng, khóa bảng đã đề cập ở trên đều là khóa bi quan.

Trong việc thực hiện các mức độ cách ly của giao dịch, cần sử dụng khóa để giải quyết vấn đề đọc ma (phantom read).

Làm thế nào để tối ưu hóa truy vấn chậm trong MySQL?

- Kiểm tra xem có sử dụng chỉ mục không; nếu không, tối ưu hóa SQL để sử dụng chỉ mục.

- Kiểm tra chỉ mục đang sử dụng, xem có phải là chỉ mục tối ưu không.

- Kiểm tra xem các trường truy vấn có phải là cần thiết không; có thể đã truy vấn quá nhiều trường, dẫn đến dữ liệu thừa.

- Kiểm tra xem dữ liệu trong bảng có quá nhiều không; có thể cần phân tách cơ sở dữ liệu và bảng.

- Kiểm tra cấu hình hiệu suất của máy chủ nơi có cơ sở dữ liệu, xem có quá thấp không; có thể tăng thêm tài nguyên nếu cần.

Trong MySQL, bảng lớn là bảng có kích thước bao nhiêu?

Chúng ta thường nói rằng bảng quá lớn, một nghĩa khác là dữ liệu quá nhiều, dẫn đến hiệu quả của chỉ mục không còn rõ ràng, chỉ có thể phân tách bảng. Vì vậy, khi thảo luận về bảng lớn là gì, cần phân tích từ góc độ chỉ mục MySQL để xác định khi nào dữ liệu trở thành bảng lớn.

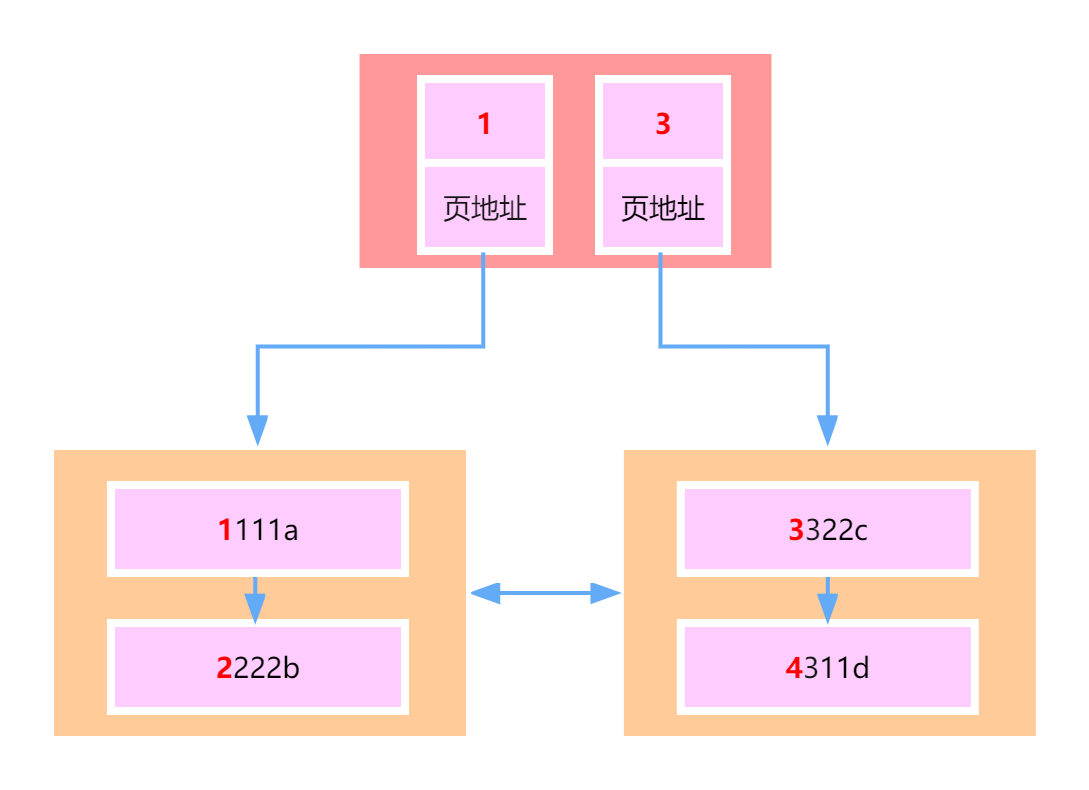

Hình trên là một chỉ mục khóa chính trong Innodb, tức là một cây B+. Mỗi nút trong cây là một trang Innodb, kích thước mặc định là 16KB, và mỗi nút lá chủ yếu lưu trữ dữ liệu, trong khi các nút không phải lá lưu trữ khóa chính và địa chỉ trang.

Vì vậy, chúng ta có thể tính toán xem nếu chiều cao của cây B+ là 2, nó có thể chứa bao nhiêu bản ghi.

- Giả sử một bản ghi là 1KB.

- Kiểu khóa chính là kiểu int, tức là một khóa chính chiếm 4 byte.

- Trong innodb, một địa chỉ trang cần chiếm 6 byte.

Vì vậy, trong một trang, tức là trong một nút, có thể chứa:

- 16KB / 1KB = 16 bản ghi dữ liệu.

- 16KB / (4B + 6B) = 1638 bản ghi chỉ mục (khóa chính + địa chỉ chỉ mục).

Vì vậy, nếu chiều cao của cây B+ là 2, thì các nút lá sẽ có 1638 nút, do đó số lượng bản ghi dữ liệu có thể lưu trữ là: 1638 * 16 = 26208 bản ghi.

Nếu chiều cao của cây B+ là 3, thì một nút ở tầng đầu tiên, 1638 nút ở tầng thứ hai, 1638 * 1638 nút ở tầng thứ ba, cuối cùng số bản ghi sẽ là: 1638 * 1638 * 16 = 42,928,704.

Tức là khoảng 40 triệu bản ghi.

Nếu kiểu khóa chính là bigint, mỗi khóa chính chiếm 8 byte, vì vậy khi chiều cao là 3, có thể lưu:

- 16KB / (8B + 6B) = 1170.

- 1170 * 1170 * 16 = 21,902,400.

Tức là hơn 20 triệu bản ghi.

Vì vậy, chúng ta có thể sử dụng phương pháp này để xác định xem số lượng dữ liệu trong một bảng có quá nhiều không (chiều cao của cây B+ thường không nên vượt quá ba tầng, vì dữ liệu của B+ tree đều được lưu trên đĩa, cây quá cao sẽ làm tăng số lần IO, và hiệu suất tổng thể sẽ giảm). Mọi người có thể sử dụng phương pháp mà tôi giới thiệu để tính số lượng bản ghi mà một bảng có thể lưu trữ khi chiều cao của B+ tree là 2 hoặc 3. Nếu tổng số bản ghi thực tế trong bảng vượt quá số lượng mà 3 tầng có thể chứa, thì bảng đó được coi là bảng lớn, lúc này hiệu suất của chỉ mục sẽ không cao, và cần phải phân tách bảng.

Sự khác biệt giữa count(*) và count(1)

Trong công việc, thường xuyên cần thực hiện thống kê, chẳng hạn như khi phân trang, cần biết tổng số dòng dữ liệu trong bảng, lúc này sẽ sử dụng count(). Vậy thì nên sử dụng count(*), count(1), hay count(cột nào đó)?

Trên trang web chính thức của MySQL, thực tế đã mô tả count(*), nhấp vào đây để xem.

Trong tài liệu chính thức, count(expr) được mô tả như sau:

Returns a count of the number of non-NULL values of expr in the rows retrieved by a SELECT statement. The result is a BIGINT value.

If there are no matching rows, COUNT() returns 0Dịch sang tiếng Việt có nghĩa là: nó trả về số lượng giá trị không NULL của biểu thức expr trong các dòng được truy vấn bởi câu lệnh SELECT. Nếu không có dòng nào phù hợp, COUNT() sẽ trả về 0.

Ví dụ với SQL dưới đây:

select count(*) from t1Là để thống kê tổng số dòng của kết quả từ câu lệnh SQL:

select * from t1Ngay sau đó, tài liệu cũng mô tả riêng về count(*):

COUNT(*) is somewhat different in that it returns a count of the number of rows retrieved, whether or not they contain NULL values.Điều này có nghĩa là count(*) có một chút khác biệt, vì count() thông thường sẽ không thống kê các giá trị NULL, nhưng count(*) sẽ thống kê cả giá trị NULL.

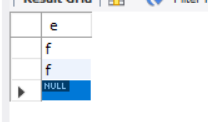

Chẳng hạn, bây giờ có một bảng với chỉ một cột và ba bản ghi, trong đó có hai giá trị f và một giá trị NULL:

Lúc này, kết quả của count(*) sẽ là 3, kết quả của count(e) sẽ là 2, và kết quả của count(1) sẽ là 3.

Trong MyISAM, sẽ có một vị trí riêng để ghi lại số lượng dòng trong bảng, vì vậy khi thực hiện count(*) trong MyISAM sẽ nhanh hơn, tất nhiên điều kiện là câu lệnh SQL không có điều kiện WHERE, vì MyISAM ghi lại tổng số dòng trong bảng không có điều kiện.

Tuy nhiên, Innodb không có cơ chế này, vì Innodb hỗ trợ giao dịch và các giao dịch có các cấp độ cách ly khác nhau. Đối với cùng một bảng, các giao dịch khác nhau có thể cùng lúc thao tác trên bảng này, và mỗi giao dịch là độc lập. Giao dịch A chèn một dữ liệu, trong khi giao dịch B có thể không cần biết đến điều đó, điều này khiến Innodb không thể ghi lại tổng số dòng giống như MyISAM.

Vậy count() trong Innodb thực hiện như thế nào? Nó sẽ sử dụng chỉ mục.

Ví dụ, khi thực hiện count(*), nó sẽ chọn một chỉ mục nào đó trong bảng, vì chỉ mục B+ tree sẽ ghi lại tất cả các dòng dữ liệu trong bảng (một số trường của mỗi dòng), nên việc sử dụng trang chỉ mục có thể thống kê tổng số dòng nhanh hơn.

Ví dụ bây giờ có một bảng với năm cột a, b, c, d, e, trong đó a là khóa chính, b, c, d là một chỉ mục kết hợp. Lúc này nếu thực hiện:

explain select count(*) from t1Sẽ thấy rằng câu lệnh SQL này sẽ sử dụng chỉ mục kết hợp bcd.

Vì chỉ mục bcd có ít trường hơn, dẫn đến số lượng nút lá trong B+ tree ít hơn, nhưng không ảnh hưởng đến số lượng dòng dữ liệu (mỗi dòng chỉ lưu trữ trường b, c, d, nói chính xác là cũng lưu a, nhưng trường e chắc chắn không có lưu).

Đó là count(*), tương tự như sẽ sử dụng chỉ mục để thống kê tổng số dòng.

Còn count(1) và count(*) thì giống nhau, như tài liệu chính thức đã mô tả:

InnoDB handles SELECT COUNT(*) and SELECT COUNT(1) operations in the same way. There is no performance difference.Nếu là count(cột nào đó), thì cũng xem cột đó có chỉ mục nào có sẵn không; nếu có thì sử dụng chỉ mục để thống kê, nếu không thì thực hiện quét toàn bộ bảng để thống kê, tất nhiên sẽ loại bỏ giá trị NULL.

Trên đây là quá trình phân tích của tôi kết hợp với tài liệu chính thức và thực nghiệm, tóm tắt như sau:

- Trong MyISAM,

count(*)nhanh hơn vì có thể lấy trực tiếp tổng số dòng do MyISAM giúp thống kê. - Trong Innodb,

count(*)sẽ chọn chỉ mục và sau đó sử dụng chỉ mục để thống kê tổng số dòng. count(1)vàcount(*)là giống nhau, không phân biệt giữa Innodb hay MyISAM.count(cột nào đó)sẽ chọn chỉ mục có sẵn của cột đó để thống kê, nếu không có thì thực hiện quét toàn bộ bảng; bất kể làcount(cột nào đó)đều sẽ loại bỏ giá trị NULL, không phân biệt có sử dụng chỉ mục hay không.

RDB và AOF là gì

RDB: Redis DataBase, là cách lưu trữ dữ liệu trong Redis bằng cách chụp ảnh (snapshot) của tập dữ liệu trong bộ nhớ và ghi vào đĩa trong các khoảng thời gian xác định. Quá trình này thực hiện bằng cách tạo một tiến trình con (fork) để ghi tập dữ liệu vào tệp tạm thời, sau khi ghi thành công, nó sẽ thay thế tệp trước đó bằng tệp đã được nén nhị phân.

Ưu điểm:

- Toàn bộ cơ sở dữ liệu Redis chỉ chứa một tệp

dump.rdb, thuận tiện cho việc lưu trữ lâu dài. - Khả năng phục hồi tốt, dễ dàng sao lưu.

- Tối đa hóa hiệu suất, tiến trình con được sử dụng để thực hiện các thao tác ghi, cho phép tiến trình chính tiếp tục xử lý lệnh, vì vậy I/O được tối đa hóa. Sử dụng tiến trình con riêng để thực hiện lưu trữ lâu dài, tiến trình chính sẽ không thực hiện bất kỳ thao tác I/O nào, đảm bảo hiệu suất cao cho Redis.

- Khi tập dữ liệu lớn, hiệu suất khởi động cao hơn so với AOF.

Nhược điểm:

- An toàn dữ liệu thấp. RDB thực hiện việc lưu trữ theo khoảng thời gian, nếu có sự cố xảy ra trong khoảng thời gian giữa hai lần lưu trữ, dữ liệu có thể bị mất. Phương pháp này phù hợp hơn với những yêu cầu dữ liệu không quá nghiêm ngặt.

- Do RDB sử dụng tiến trình con để hỗ trợ thực hiện công việc lưu trữ dữ liệu, nên khi tập dữ liệu lớn, có thể làm toàn bộ máy chủ ngừng hoạt động từ vài trăm mili giây đến một giây.

AOF: Append Only File, ghi lại mọi thao tác ghi và xóa mà máy chủ xử lý dưới dạng nhật ký. Các thao tác truy vấn sẽ không được ghi lại và được lưu dưới dạng văn bản, có thể mở tệp để xem chi tiết các thao tác đã thực hiện.

Ưu điểm:

- An toàn dữ liệu, Redis cung cấp ba chính sách đồng bộ: đồng bộ mỗi giây, đồng bộ mỗi lần thay đổi và không đồng bộ. Thực tế, đồng bộ mỗi giây cũng được thực hiện không đồng bộ, với hiệu suất cao. Sự khác biệt là nếu hệ thống gặp sự cố, dữ liệu đã thay đổi trong giây đó sẽ bị mất. Trong khi đồng bộ mỗi lần thay đổi, chúng ta có thể coi như lưu trữ đồng bộ, tức là mỗi thay đổi dữ liệu sẽ ngay lập tức được ghi vào đĩa.

- Thông qua chế độ ghi append, ngay cả khi máy chủ gặp sự cố giữa chừng, nội dung đã tồn tại sẽ không bị hỏng, có thể sử dụng công cụ

redis-check-aofđể giải quyết vấn đề nhất quán dữ liệu. - Chế độ ghi lại (rewrite) của cơ chế AOF. Thực hiện ghi lại định kỳ tệp AOF để đạt được mục đích nén.

Nhược điểm:

- Tệp AOF lớn hơn tệp RDB và tốc độ phục hồi chậm hơn.

- Khi tập dữ liệu lớn, hiệu suất khởi động thấp hơn RDB.

- Hiệu suất chạy không cao bằng RDB.

Tệp AOF có tần suất cập nhật cao hơn tệp RDB, ưu tiên sử dụng AOF để khôi phục dữ liệu. AOF an toàn hơn và lớn hơn, trong khi RDB có hiệu suất tốt hơn AOF. Nếu cả hai đều được cấu hình, ưu tiên tải AOF trước.

Chiến lược xóa khóa hết hạn trong Redis

Redis là cơ sở dữ liệu key-value, cho phép chúng ta thiết lập thời gian hết hạn cho các khóa lưu trữ trong Redis. Chiến lược hết hạn của Redis chỉ ra cách Redis xử lý khi một khóa hết hạn.

- Hết hạn lười biếng (Lazy Expiration): Chỉ kiểm tra khóa đã hết hạn khi có truy cập đến khóa đó; nếu hết hạn thì sẽ xóa. Chiến lược này tiết kiệm tối đa tài nguyên CPU nhưng không thân thiện với bộ nhớ. Trong tình huống cực đoan, có thể có nhiều khóa hết hạn không được truy cập lại, dẫn đến việc không bị xóa và chiếm dụng một lượng lớn bộ nhớ.

- Hết hạn định kỳ (Periodic Expiration): Mỗi khoảng thời gian nhất định, sẽ quét một số lượng khóa nhất định trong từ điển

expirescủa cơ sở dữ liệu và xóa các khóa đã hết hạn. Chiến lược này là một phương án thỏa hiệp. Bằng cách điều chỉnh khoảng thời gian quét định kỳ và thời gian quét mỗi lần, có thể tối ưu hóa tài nguyên CPU và bộ nhớ trong các tình huống khác nhau.

(Từ điển expires sẽ lưu trữ tất cả các dữ liệu thời gian hết hạn của khóa đã được thiết lập thời gian hết hạn. Trong đó, khóa là con trỏ đến một khóa trong không gian khóa, giá trị là thời gian hết hạn được biểu diễn bằng dấu thời gian UNIX với độ chính xác mili giây. Không gian khóa là tất cả các khóa được lưu trữ trong cụm Redis.)

Redis sử dụng đồng thời cả hai chiến lược hết hạn lười biếng và hết hạn định kỳ.

Tóm tắt việc thực hiện giao dịch trong Redis

1. Bắt đầu giao dịch

Thực hiện lệnh _MULTI_ đánh dấu bắt đầu một giao dịch. Lệnh _MULTI_ sẽ mở cờ REDIS_MULTI trong thuộc tính flags của trạng thái máy khách.

2. Lệnh được xếp hàng

Khi một máy khách chuyển sang trạng thái giao dịch, máy chủ sẽ thực hiện các thao tác khác nhau dựa trên các lệnh mà máy khách gửi đến. Nếu lệnh được gửi là một trong các lệnh _MULTI_, _EXEC_, _WATCH_, _DISCARD_, máy chủ sẽ thực hiện ngay lệnh đó, nếu không thì lệnh sẽ được đưa vào một hàng đợi giao dịch, sau đó gửi phản hồi QUEUED cho máy khách.

- Nếu lệnh được máy khách gửi là một trong bốn lệnh EXEC, DISCARD, WATCH, MULTI, máy chủ sẽ thực hiện ngay lệnh đó.

- Nếu lệnh được máy khách gửi là các lệnh khác ngoài bốn lệnh trên, máy chủ sẽ không thực hiện ngay lệnh đó. Đầu tiên, kiểm tra định dạng của lệnh có đúng không, nếu không đúng, máy chủ sẽ tắt cờ

REDIS_MULTItrong thuộc tính trạng thái của máy khách (redisClient) và gửi thông tin lỗi cho máy khách. Nếu đúng, lệnh sẽ được đưa vào hàng đợi giao dịch và gửi phản hồiQUEUEDcho máy khách.

Hàng đợi giao dịch sẽ lưu trữ các lệnh theo cách FIFO (first in, first out).

3. Thực thi giao dịch

Khi máy khách gửi lệnh EXEC, máy chủ sẽ thực hiện logic của lệnh EXEC.

- Nếu thuộc tính

flagscủa trạng thái máy khách không chứa cờREDIS_MULTI, hoặc chứa các cờREDIS_DIRTY_CAShoặcREDIS_DIRTY_EXEC, thì giao dịch sẽ bị hủy bỏ. - Nếu không, máy khách đang ở trạng thái giao dịch (có cờ

REDIS_MULTI), máy chủ sẽ duyệt qua hàng đợi giao dịch của máy khách và thực hiện tất cả các lệnh trong hàng đợi, cuối cùng sẽ trả lại tất cả kết quả cho máy khách.

Redis không hỗ trợ cơ chế rollback (hoàn tác) giao dịch, nhưng nó sẽ kiểm tra xem từng lệnh trong giao dịch có bị lỗi hay không.

Giao dịch Redis không hỗ trợ kiểm tra những lỗi logic do lập trình viên tự gây ra. Ví dụ, thực hiện thao tác trên kiểu dữ liệu HashMap đối với một khóa kiểu String!

- Lệnh

WATCHlà một khóa lạc quan, có thể cung cấp hành vi kiểm tra và thiết lập (check-and-set - CAS) cho giao dịch Redis. Nó có thể theo dõi một hoặc nhiều khóa, và một khi bất kỳ khóa nào trong số đó bị thay đổi (hoặc xóa), giao dịch sau đó sẽ không được thực hiện, việc theo dõi sẽ tiếp tục cho đến khi lệnhEXECđược thực hiện. - Lệnh

MULTIđược sử dụng để bắt đầu một giao dịch, nó luôn trả về OK. Sau khi thực hiệnMULTI, máy khách có thể tiếp tục gửi bất kỳ số lượng lệnh nào tới máy chủ, những lệnh này sẽ không được thực hiện ngay lập tức mà sẽ được đưa vào một hàng đợi, và khi lệnhEXECđược gọi, tất cả các lệnh trong hàng đợi mới được thực hiện. - Lệnh

EXEC: thực hiện tất cả các lệnh trong khối giao dịch. Trả về giá trị trả về của tất cả các lệnh trong khối giao dịch, theo thứ tự thực hiện. Khi thao tác bị gián đoạn, trả về giá trị rỗngnil. - Bằng cách gọi lệnh

DISCARD, máy khách có thể làm trống hàng đợi giao dịch và từ bỏ việc thực hiện giao dịch, đồng thời máy khách sẽ thoát khỏi trạng thái giao dịch. - Lệnh

UNWATCHcó thể hủy bỏ việc theo dõi tất cả các khóa.

Nguyên lý cốt lõi của sao chép master-slave trong Redis

Bằng cách thực hiện lệnh slaveof hoặc thiết lập tùy chọn slaveof, cho phép một máy chủ sao chép dữ liệu từ máy chủ khác. Cơ sở dữ liệu chính có thể thực hiện các thao tác đọc và ghi, khi các thao tác ghi gây ra sự thay đổi dữ liệu, dữ liệu sẽ tự động được đồng bộ đến cơ sở dữ liệu từ. Cơ sở dữ liệu từ thường chỉ là đọc, và nhận dữ liệu đồng bộ từ cơ sở dữ liệu chính. Một cơ sở dữ liệu chính có thể có nhiều cơ sở dữ liệu từ, trong khi một cơ sở dữ liệu từ chỉ có thể có một cơ sở dữ liệu chính.

Sao chép toàn bộ:

- Cơ sở dữ liệu chính thông qua lệnh

bgsavetạo một tiến trình con để thực hiện lưu trữ RDB, quá trình này rất tiêu tốn CPU, bộ nhớ (sao chép bảng trang) và I/O ổ cứng. - Cơ sở dữ liệu chính sẽ gửi tệp RDB qua mạng cho cơ sở dữ liệu từ, điều này sẽ tiêu tốn băng thông của cả hai máy chủ.

- Quá trình từ cơ sở dữ liệu từ làm sạch dữ liệu cũ và tải tệp RDB mới là quá trình chặn (blocking), không thể phản hồi các lệnh từ máy khách; nếu cơ sở dữ liệu từ thực hiện

bgrewriteaof, điều này cũng sẽ dẫn đến tiêu tốn thêm tài nguyên.

Sao chép một phần:

- Offset sao chép: Cả hai bên thực hiện sao chép, cơ sở dữ liệu chính và từ, sẽ duy trì một offset sao chép riêng.

- Bộ đệm sao chép: Cơ sở dữ liệu chính nội bộ duy trì một hàng đợi FIFO (first in, first out) có độ dài cố định làm bộ đệm sao chép. Khi độ chênh lệch giữa offset của máy chủ chính và từ vượt quá độ dài của bộ đệm, việc thực hiện sao chép một phần sẽ không khả thi và chỉ có thể thực hiện sao chép toàn bộ.

- ID máy chủ chạy (runid): Mỗi nút Redis đều có ID chạy của nó, ID này được tự động tạo ra khi nút khởi động. Cơ sở dữ liệu chính sẽ gửi ID chạy của mình đến cơ sở dữ liệu từ, cơ sở dữ liệu từ sẽ lưu giữ ID chạy của cơ sở dữ liệu chính. Khi cơ sở dữ liệu từ Redis kết nối lại, nó sẽ dựa vào ID chạy để xác định tiến độ đồng bộ:

- Nếu

runidđược lưu trong cơ sở dữ liệu từ giống vớirunidhiện tại của cơ sở dữ liệu chính, điều này có nghĩa là cơ sở dữ liệu chính và từ đã đồng bộ trước đó, cơ sở dữ liệu chính sẽ tiếp tục cố gắng sử dụng sao chép một phần (có thể thực hiện sao chép một phần hay không còn phụ thuộc vào tình hình offset và bộ đệm sao chép); - Nếu

runidđược lưu trong cơ sở dữ liệu từ khác vớirunidhiện tại của cơ sở dữ liệu chính, điều này có nghĩa là cơ sở dữ liệu từ đã đồng bộ với nút Redis trước đó không phải là cơ sở dữ liệu chính hiện tại, chỉ có thể thực hiện sao chép toàn bộ.

- Nếu

Các cấu trúc dữ liệu trong Redis là gì? Mỗi cấu trúc có những trường hợp ứng dụng điển hình nào?

Cấu trúc dữ liệu của Redis có:

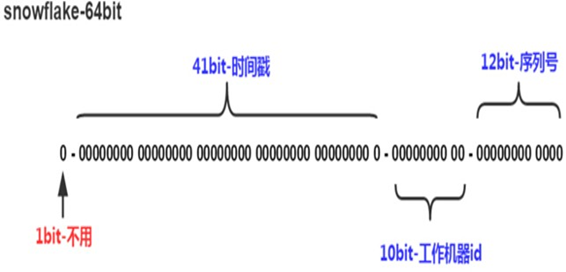

- Chuỗi (String): Có thể được sử dụng để làm dữ liệu đơn giản nhất, có thể lưu trữ một chuỗi đơn giản hoặc một chuỗi định dạng JSON, việc thực hiện khóa phân tán trong Redis sử dụng cấu trúc dữ liệu này, cũng như có thể thực hiện các bộ đếm, chia sẻ phiên (Session), ID phân tán.

- Bảng băm (Hash): Có thể được sử dụng để lưu trữ một số cặp key-value, thích hợp hơn để lưu trữ các đối tượng.

- Danh sách (List): Danh sách trong Redis có thể được sử dụng như ngăn xếp (stack) hoặc hàng đợi (queue) nhờ vào các lệnh kết hợp, có thể dùng để lưu trữ dữ liệu dòng tin nhắn từ các ứng dụng như WeChat, Weibo.

- Tập hợp (Set): Tương tự như danh sách, cũng có thể lưu trữ nhiều phần tử nhưng không được trùng lặp, có thể thực hiện các phép toán giao, hợp và hiệu của tập hợp, từ đó có thể thực hiện các chức năng như: người mà tôi và ai đó cùng theo dõi, tương tác trong vòng bạn bè.

- Tập hợp có thứ tự (Sorted Set): Tập hợp không có thứ tự, nhưng tập hợp có thứ tự có thể thiết lập thứ tự, có thể được sử dụng để thực hiện chức năng bảng xếp hạng.

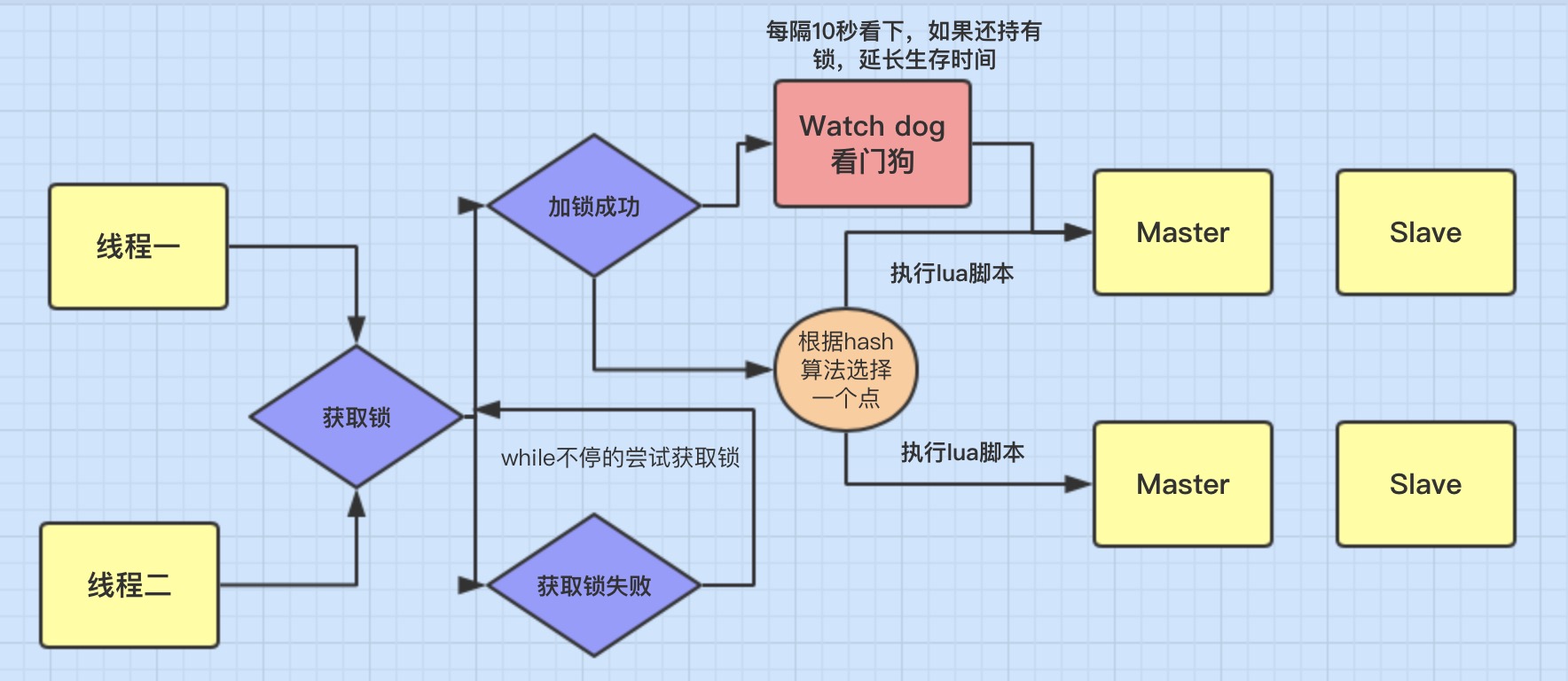

Cách thức hoạt động của khóa phân tán trong Redis?

- Đầu tiên, sử dụng

setnxđể đảm bảo: nếu khóa không tồn tại thì mới có thể nhận được khóa, nếu khóa tồn tại, không thể nhận được khóa. - Tiếp theo, cần sử dụng Lua Script để đảm bảo tính nguyên tử của nhiều thao tác Redis.

- Đồng thời cần xem xét đến việc khóa hết hạn, vì vậy cần có một tác vụ watchdog định kỳ để theo dõi xem khóa có cần gia hạn hay không.

- Đồng thời cũng cần xem xét tình huống khi nút Redis gặp sự cố, vì vậy cần sử dụng phương pháp Redlock để đồng thời yêu cầu khóa từ N/2+1 nút, chỉ khi tất cả đều nhận được khóa thì mới xác nhận việc nhận khóa thành công. Như vậy, ngay cả khi một trong các nút Redis gặp sự cố, khóa cũng không thể được nhận bởi các máy khách khác.

Nguyên lý cốt lõi của sao chép chính - phụ trong Redis (master-slave replication)

Sao chép chính - phụ trong Redis là một biện pháp hiệu quả để tăng tính đáng tin cậy của Redis. Quy trình sao chép chính - phụ như sau:

- Khi khởi động cụm, hệ thống sẽ thiết lập kết nối giữa cơ sở dữ liệu chính và phụ để chuẩn bị cho việc sao chép toàn bộ dữ liệu.

- Cơ sở dữ liệu chính sẽ đồng bộ tất cả dữ liệu sang cơ sở dữ liệu phụ. Sau khi nhận dữ liệu, cơ sở dữ liệu phụ sẽ tải dữ liệu lên bộ nhớ địa phương, quá trình này phụ thuộc vào snapshot bộ nhớ RDB.

- Trong quá trình đồng bộ dữ liệu từ cơ sở dữ liệu chính sang cơ sở dữ liệu phụ, cơ sở dữ liệu chính sẽ không bị chặn, vẫn có thể xử lý các yêu cầu bình thường. Tuy nhiên, các thao tác ghi trong những yêu cầu này sẽ không được ghi lại vào file RDB mới tạo. Để đảm bảo tính nhất quán của dữ liệu giữa cơ sở dữ liệu chính và phụ, cơ sở dữ liệu chính sẽ sử dụng một replication buffer (bộ nhớ đệm sao chép) trong bộ nhớ để ghi lại tất cả các thao tác ghi xảy ra trong quá trình tạo file RDB.

- Cuối cùng, sau khi hoàn thành việc gửi file RDB, cơ sở dữ liệu chính sẽ gửi các lệnh ghi mới nhận được trong quá trình này từ replication buffer sang cơ sở dữ liệu phụ để cơ sở dữ liệu phụ thực hiện các lệnh này, từ đó đạt được sự đồng bộ.

- Sau đó, cả cơ sở dữ liệu chính và phụ đều có thể xử lý các thao tác đọc của máy khách, nhưng chỉ có cơ sở dữ liệu chính mới xử lý được các thao tác ghi. Cơ sở dữ liệu chính sẽ gửi các thao tác ghi tới cơ sở dữ liệu phụ để thực hiện đồng bộ gia tăng.

Chiến lược Redis cluster

Redis cung cấp ba chiến lược cluster:

Chế độ chính - phụ: Chế độ này khá đơn giản, cơ sở dữ liệu chính có thể đọc và ghi, đồng thời đồng bộ dữ liệu với cơ sở dữ liệu phụ. Tuy nhiên, khi cơ sở dữ liệu chính hoặc phụ bị hỏng, cần phải sửa đổi IP thủ công và chế độ này khó mở rộng. Dữ liệu của toàn bộ cụm bị giới hạn bởi dung lượng bộ nhớ của một máy, do đó không thể hỗ trợ lượng dữ liệu quá lớn.

Chế độ Sentinel: Trên cơ sở chính - phụ, thêm vào các nút Sentinel. Khi cơ sở dữ liệu chính gặp sự cố, Sentinel sẽ phát hiện và chọn một cơ sở dữ liệu phụ trở thành cơ sở dữ liệu chính mới. Sentinel cũng có thể tạo thành cụm để đảm bảo khi một Sentinel gặp sự cố, vẫn còn các Sentinel khác tiếp tục làm việc. Tuy nhiên, chế độ này vẫn không thể giải quyết tốt vấn đề giới hạn dung lượng của Redis.

Chế độ Cluster: Đây là chế độ được sử dụng phổ biến nhất, hỗ trợ nhiều cơ sở dữ liệu chính và phụ. Chế độ này phân chia các slot theo key để phân tán các key khác nhau tới các nút chính khác nhau, giúp cụm hỗ trợ dung lượng dữ liệu lớn hơn. Mỗi nút chính có thể có nhiều nút phụ, và khi nút chính gặp sự cố, một nút phụ sẽ được bầu chọn làm nút chính mới.

Đối với ba chế độ này, nếu lượng dữ liệu Redis cần lưu trữ không lớn, có thể chọn chế độ Sentinel. Nếu dữ liệu lớn và cần mở rộng liên tục, nên chọn chế độ Cluster.

Cache xuyên thấu, cache đâm thủng, và cache sụp đổ là gì?

Trong cache thường lưu trữ các dữ liệu "nóng" nhằm tránh việc phải truy cập trực tiếp vào MySQL. Các vấn đề có thể xảy ra là:

Cache sụp đổ: Khi một lượng lớn dữ liệu "nóng" hết hạn cùng lúc, sẽ dẫn đến lượng lớn các yêu cầu truy cập trực tiếp vào MySQL. Cách giải quyết là thêm một số giá trị ngẫu nhiên vào thời gian hết hạn hoặc xây dựng cụm Redis có tính khả dụng cao.

Cache đâm thủng: Khác với cache sụp đổ là nhiều dữ liệu cùng hết hạn, cache đâm thủng xảy ra khi một key "nóng" đột ngột hết hạn, dẫn đến lượng lớn yêu cầu truy cập trực tiếp vào MySQL. Giải pháp là không đặt thời gian hết hạn cho key "nóng".